Critique de livres

"Doctus cum livro"

"Si vous n'apprenez pas à penser par vous même, d'autres le

feront pour vous " - JP Petit

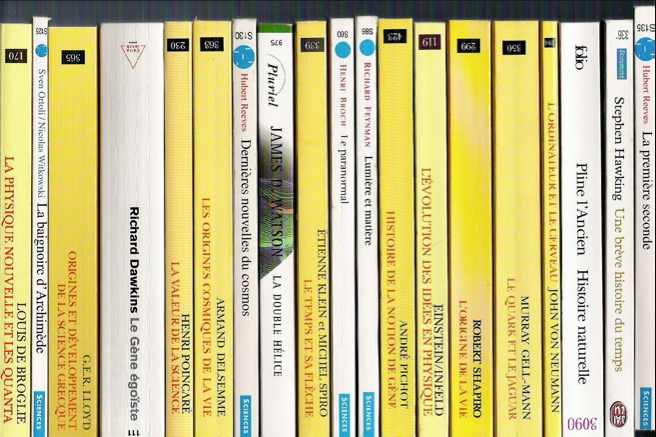

les critiques sont en cours.... (Ma bibliothèque est

fournie) seuls les titres en gras sont analysés pour le

moment....

André Pichot -

histoire de la notion de

gène. Champs, Flammarion, 1999 ---

4/20

Etienne Klein -

Il était sept fois la Révolution : Albert Einstein et les

autres... 2005 ---- 16/20

Murray

Gell-Mann: Le Quark et le Jaguar :

Voyage au cœur du simple et du

complexe. Champs,

Flammarion----- 16/20

Stephen Wolfram: A New Kind of Science ----- 15/20

E. Hecht: Physique ----- 17/20

R.

Thom: prédire n'est pas

expliquer ----13/20

N. Witkowski

- Une histoire

sentimentale des sciences ---- 18/20

B Greene

- l'Univers

élégant ---

17/20

B

Greene: la magie du

cosmos ---

19/20

Von Neumann

- L'ordinateur et le

cerveau ---- 15/20

Eléments d'histoire des sciences - Refèrences Bordas - Sous

la direction de M Serres.

B

Teyssèdre - La vie invisible

- les 3 premiers milliards

d'années de l'histoire de la vie sur

Terre. Ed.

L'Harmattan. --- 16/20

André Pichot - histoire de la notion de gène. Champs, Flammarion, 1999

ISBN 2-08081423-0

Le Livre de “Mr” Pichot est de prime abord intéressant: on s’attend à y trouver exposer l’histoire de la notion de gène, base de la biologie moderne. Hélas, cet universitaire épistémologue se complet dans une “alter” biologie qu’il critique vertement sans paraître comprendre un traître mot aux notions postérieures aux années 50.

En effet, l'œuvre de Pichot s’articule autour de trois axes:

- la réhabilitation de Lamarck, ce qui est utile et bien réalisé.

- la critique des conséquences sociales de la génétique et de l’eugénisme en particulier, la génétique étant rendue responsable des sociétés l’utilisant peu ou prou pour sélectionner leurs concitoyens.

- la dénonciation de la génétique moderne, laquelle ne serait qu’un vide conceptuel béant, sans aucune base théorique valable...

L’horreur vertueuse et philosophique de la sélection conduit Mr Pichot à des extrémités regrettables et a des conceptions erronées. Son discours est truffé de répétitions souvent inutiles, de digressions sans grand intérêt, sinon celui de se persuader soi même d’être dans le vrai. Ainsi, le camarade Pichot (il faut bien l’appeler par son nom) en vient à réhabiliter Lyssenko! Comme nombre d’intellectuels français confits dans le marxisme, la notion même d’hérédité, c’est à dire, in fine, celle de l’héritage d’un ordre, est intolérable à ceux qui ont proclamé “du passé, faisons table rase”. Ainsi, la vision de l”historicité des processus épistémophiliques de l’auteur demeure hémiplégique: fasciné et justement horrifié par les déviances nazies, il en “oubli” volontairement les millions de morts provoqués par l’application des doctrines de son ami Lyssenko...

De fait, Pichot rappelle, avec force soupirs, avoir lu l’intégralité des textes aussi encyclopédiques qu’imbuvables de Weismann et De Vries, ce qui explique sans doute pourquoi il s’est apparemment dispensé d’ouvrir un ouvrage tout aussi épais, mais moderne de biologie moléculaire (comme par exemple le classique “biologie moléculaire du gène”, de Watson). Il en reste au schéma “un gène- une enzyme”, qui n’est plus actuel. Qui plus est, alors que l’histoire du gène est bien exposée jusque vers 1950 environ, il recule ensuite pour revenir à ses grimoires: il semble bien que pour Mr Pichot, une “vraie ” science de l’hérédité est faite de ratiocinations de vénérables et doit surtout se garder de toute application pratique (c’est gênant, toutes ces sales expériences qui polluent les belles théories - notre épistémologue de salon semble avoir oublié que “the tragedy of science is the murder of beautiful theories by ugly facts”). Notre littérateur engagé semble passer à côté des critères réels de la scientificité et néglige, omet, déforme ou passe sous silence (attitude marxiste typique) les faits qui dérangent sa tranquille (et théorique) ire antiscientifique. Donnons quelques exemples de ces errements:

p 227: suggestion qu’un ordre aléatoire de nucléotide est équivalent à un gène. Reste a expliquer alors l’effet dévastateur des mutations et délétions.

p 242 : Le bon Mr Pichot ignore complètement ce que sont les ARN

p 268 : Le camarade Pichot ignore ce qu’est la théorie synthétique de l’évolution, et nous ressort des arguments spécieux visant à démontrer selon lui l’inanité de l’évolution (argument d’actualité, il date de... Cuvier!). Malheureusement, non seulement les séparations actuelles des plans d’organisation ne prouvent rien, mais l’on a depuis découvert d’autres taxons disparus (cf “la vie est belle” de Gould), ainsi que des formes intermédiaires entre les taxons, apparus au cours de l’évolution (neopillidina, Lizzie, le célèbre archaeopteryx bien sûr, mais aussi Acanthostega, Protarchaeopteryx, iberomesornis ...)

Ce qui revient comme un leitmotiv dans le deuxième partie de l’ouvrage, c’est le dégout de l’auteur pour toutes les applications pratiques et les succès obtenus par la génétique. Bien entendu, ces succès sont, pour l’auteur, peu important. En effet, ce dernier ne s’intéresse qu’à l’être humain (survalorisation qui indique à la fois les limites de son analyse et son désir de séparer ce dernier des autres êtres vivants, ce qui se comprend puisque pour le sieur Pichot, l’évolution n’existe pas...) et néglige complètement le fait que les techniques de biologie moléculaire visant à transférer ou inactiver un gène sont à présent des techniques de routine employées quotidiennement dans les laboratoires: que cela plaise ou non à Mr Pichot, le succès répété des techniques expérimentales (souris “knock out” par exemple, où transgéniques) valident grandement les conceptions actuelles du gène.

Bien entendu, ces conceptions peuvent être critiquées: bien qu’expédiées en peu de lignes, les approches critiques de P. Soligno ou H. Atlan sont à cet égard bien plus constructive que les cris d’orfraie d’un homme qui, déplorant l’utilisation de la génétique par le régime nazi, choisi de jeter le bébé avec l’eau du bain...

Au final, on peut cependant recommander l’ouvrage :

- pour sa belle mise en évidence du rôle de Lamarck dans l’histoire des sciences et son analyse lumineuse des conceptions de de Vries et Weissman.

- ses rappels des limites de la méthode expérimentale.

- Pour analyser à quel point des spécialistes des dites “sciences” humaines peuvent discourir dans le vide et pratiquer ouvertement un négationnisme, voire un nihilisme antiscientifique qui ne saurait combler d’aise que ceux qui prennent José Bové pour le phare de la pensée biologique contemporaine

Murray Gell-Mann: Le Quark et le Jaguar : Voyage au cœur du simple et du complexe

L'auteur a reçu le prix Nobel de physique en 1969, pour sa théorie des quarks, constituants extrêmes de la matière.

Dans ce livre, il analyse comment évolue la complexité des phénomènes depuis l'échelle subatomique jusqu'à l'échelle macroscopique. L'ensemble est extrêmement intéressant, bien écrit et convenablement traduit. L'auteur insiste longuement sur le Santa Fe Institute, qu'il a créé, et milite pour un progrès technique respectueux de l'environnement. C'est à ce niveau que certains de ses arguments se révèlent un brin léger.

Toutefois, ce livre éclaire convenablement la genèse de la complexité, et insiste à juste titre sur les notions de régularités. Quelques remarques:

p.68: "la complexité effective est ainsi liée à la description des régularités d'un système par un système adaptatif complexe qui l'observe" : il me semble que cette définition est autoréférente: la complexité nécessite, pour être définie, l'existence d'une structure en elle-même complexe. Mais qu'est-ce qu’une structure complexe? et bien, c'est une description des régularités ect.... Heureusement, les choses s'éclaircissent quelques pages plus loin (p. 74): "la complexité effective d'une entité... est la longueur d'une description concise des régularités de l'entité" . On retrouve ici les idées de Kolmogorov.

p. 121-122: l'auteur présente les notions très intéressantes de profondeur et de crypticité, développées par C. Bennet. Il mentionne auparavant que "dans une étonnante variété de contextes, des structures de comportement apparemment complexe émergent de systèmes caractérisés par de très simples règles". Il ne s'y attarde guère, mais il s'agit bien ici des phénomènes recensés et développés ultérieurement par S. Wolfram dans son ouvrage "a new kind of science".

Le passage du quantique au classique est particulièrement bien traité (chapitre 11: "un regard contemporain sur la mécanique quantique"). d'agraindissement en décohérence, on sort de ces chapitres moins bêtes qu'en y étant entrés. Leur lecture devrait être obligatoire en premier cycle de sciences....

L'auteur pose une excellente question p 221: comment se fait-il qu'il y ait tellement de particules "élémentaires" (il en compte 61 !) ? Il voit bien là la nécessité d'une théorie "unifiée" explicitant cet état de fait, et propose trois pistes à explorer:

- les 61 particules sont en fait composées d'autres particules inconnues, en nombre plus réduit. Aucun indice de cela n'existe.

- les 61 particules sont composées de particules qui elles-mêmes sont composées de particules.... sans fin. Cette idée puissante ayant été proposée par le président Mao, nous vous laissons juge de sa pertinence...

- les particules sont en nombre infini, mais seul un petit nombre est détectable, du fait de leur origine à partir d'objets uniques, les supercordes (voir Greene, l'univers élégant, en film ou en livre)

L'auteur n'envisage pas une autre possibilité, faisant des particules des objets topologiques résultants de projections dans notre espace-temps de phénomènes se déroulant dans des dimensions différentes (bien que ce concept de dimensions surnuméraires pose problème, même pour les supercordes)

P 248 et suivantes, l'auteur décrit clairement les rapports entre la notion d'entropie, et celle, plus nouvelle d'information.

Les êtres vivants sont considérés comme des "systèmes adaptatifs complexes" qui (p. 306): "identifient des régularités dans le flux de données qu'ils reçoivent et compressent ces régularités en schémas. " cette définition est extrêmement pertinente.

L'impossibilité d'un déterminisme strict (et donc d'une prédictibilité absolue des phénomènes) est analysée par l'auteur qui ne se limite pas aux caractères probabilistes de la mécanique quantique. Il identifie 5 origines pour l'indéterminisme :

- les indéterminations quantiques

- le comportement chaotique

- l'"agraindissement" provoqué par "l'étroitesse du spectre couvert par nos sens et nos instruments et leur capacité limitée "

- l'insuffisance de notre faculté de comprendre

- les limites de notre capacité de calcul.

Il y a également quelques "erreurs", en particulier dans le domaine biologique, causées pour la plupart , en fait, par des découvertes survenues depuis la publication de l'ouvrage en 1994:

p.87 : "il existe quelques légers signes en biologie de mutations survenues comme réponses occasionnelles à un besoin". J'avoue qu'une référence n'aurait pas été de trop, car ce singulier phénomène n'existe pas, je crois (et même l'auteur ne semble pas persuadé de sa véracité).

p. 88: "la complexité de la bactérie est liée à la longueur de son génome": On a découvert depuis que la longueur d'un génome était un piètre indice de complexité effective ! De même, à la page suivante, l'auteur pense qu'il est nécessaire de rajouter des notions plus fines pour différencier la complexité humaine de celle des grands singes. Je pose la question: existe t'il réellement des différences de complexité à ce niveau ? Une grande partie de l'évolution biologique semble s'être déroulée, selon moi, à complexité constante.

Pour les pédagogues, Gell Mann apporte quelques lueurs sur la pratique des sciences:

" En pratique, l'entreprise scientifique ne se conforme pas exactement à un quelconque modèle précis dictant les règles de sa conduite" p 99

p 130 "les mathématiques ne sont-elles pas la plus fondamentale des sciences ?"

p 137 "la biologie est une science bien plus complexe que la physique fondamentale, car nombre des régularités de la vie terrestre résultent autant d'événements accidentels que de lois fondamentales"

p 302 -303: l'"histoire du baromètre" (parfois faussement considérée comme autobiographique et concernant la jeunesse de Planck) vous permettra de voir qu'en physique, il n'y a pas, contrairement à ce qui est enseigné, une seule solution à un problème donné...

Superstition et besoin de croire (p 314): " ils apaisent leur crainte de l'aléatoire par la détection de régularités... absentes."

En résumé, un excellent livre que tout homme de science se doit d'avoir lu.

Von Neumann - L'ordinateur et le cerveau

Un petit livre très intéressant, que l'on pourrait croire d'un intérêt seulement historique au vu de l'évolution technique depuis 1957, mais qui présente une grande importance pour comprendre la genèse de l'informatique et, surtout, pour mettre en parallèle la logique du vivant (cerveau) et celle des machines.

Plusieurs notes dans le texte réactualisent beaucoup de données, et le commentaire de D Pignon (40 pages sur les 128 de l'ouvrage) complète fort bien les textes de V. Neumann.

Quelques points importants:

- p. 77, V. Neumann remarque que la précision du cerveau est très inférieure à celle des calculateurs, et mentionne bien que " Le système nerveux est un ordinateur qui parvient à accomplir sa tâche extraordinairement complexe à un niveau assez faible de précision (...) 2 à 3 décimales seulement sont possibles. Aucun ordinateur connu ne peut opérer de façon fiable et pertinente avec une précision aussi faible".

- p. 111:, D Pigeon souligne l'apport de V Neumann à la théorie des automates cellulaires dont la protée, depuis le recueil publié par S. Wolfram, ne cesse de croître. Ainsi, comme le rappelle Pignon "Mc Culloch et Pitts ont formalisé cette physiologie des tissus nerveux avec la modélisation des réseaux formels de neurones et ont démontré que les états de ces systèmes sont isomorphes aux propositions de la logique: tout ce qu'une machine de Turing peut faire, un réseau de neurones formel le peut aussi.»

Les pages suivantes comptent parmi les plus importantes de l'ouvrage (bien qu'elles ne soient pas de V Neumann!) avec une mise en lumière du caractère non algorithmique du fonctionnement cérébral. Toutefois, un point peut être discuté: l'auteur précise (p. 119) que "la densité des circuits électroniques est limitée par des contraintes thermiques et de fabrication de structures planes, alors que le cerveau enchevêtre ses neurones dans l'espace". Ce n'est pas exact, les corps neuronaux de la structure cérébrale correspondant à la conscience, le cortex, ne se réarrangent pas dans l'espace mais bel et bien à la surface du cerveau. L'augmentation des capacités cérébrales est d'ailleurs lié à l'augmentation non du volume, mais de la surface corticale, aboutissant ainsi à un plissement de plus en plus marqué des hémisphères cérébraux au fur et à mesure que l'intelligence se développait dans le monde animal. L'épaisseur du cortex ne dépasse pas trois couches cellulaires, le plus souvent...

Par contre, comme le remarque Pignon, "Pour atteindre la densité neuronale du cerveau, "il faudrait empiler dans un cube de 1 cm des centaines de processeurs ultraminces, qui travailleront un million de fois plus vite que les unités actives du cerveau.". On peut même se demander si ce n'est pas cette vitesse d'exécution qui pose problème, et si la conscience ne procède pas, au moins en partie, de la lenteur "relative" des procédés physico-chimiques à l'oeuvre dans les neurones.

-p. 121: "La comparaison des structures du cerveau et de la manière de traiter l'information qui y sont associé avec le calcul mécanique des ordinateurs conduit VN à considérer la logique comme un avatar culturel de l'évolution et à envisager une structure profonde du calcul, plus archaïque dans ses modalités, sans doute radicalement différentes de celle que nous connaissons." Il s'agit là d'une idée intéressante, celle selon laquelle la logique serait contingente à l'évolution biologique. Si le "calcul" est ainsi inscrit, dès l'origine, dans le vivant, alors nous pouvons logiquement (c'est le cas de le dire) supposer que le développement de la logique se produit immanquablement au cours du processus de l'évolution biologique, donc qu'une évolution extraterrestre engendrerait très probablement des organismes nantis de logique. L'intelligence serait-elle donc aussi répandue que la vie à travers la galaxie ?

Thom R - prédire n'est pas expliquer

Ce livre est une transcription des entretiens entre Emile Noel et R Thom, suivi d'un lexique présentant utilement les notions mentionnées par Thom, et réalisé par A Chenciner (ce lexique contient des schémas intéressants, mais de mauvaise qualité)

On est frappé, dans ce livre, par le ton de Thom et sa grande difficulté à penser la physique, et pour ainsi dire le réel. Ces rapports entre réalité(s) et mathématiques constituent la substance de cet ouvrage intéressant, bien que les opinions de Thom puissent être discutées. Comme beaucoup de scientifiques, Thom dénie toute valeur aux sciences qui ne font pas partie de son champ de recherche. Il se montre obtus et étroit d'esprit. Ainsi, p. 81, ne craint-il pas d'affirmer "De quel droit déclarez-vous qu'un neurophysiologiste a un savoir plus pertinent que ma propre impression ? Je refuse cet argument". Il oublie ainsi qu'il ne s'agit pas de droit, mais de sciences et de faits démontrés expérimentalement. Mais l'expérience embarrasse beaucoup R. Thom, qui manifeste un grande incompréhension de la physique quantique, par exemple. Il ne craint pas de déclarer (p. 86) "La mécanique quantique est incontestablement le scandale intellectuel du siècle" car "la science a renonça à l'intelligibilité du monde", rien que ça! On pourrait au contraire arguer que la mécanique quantique nous permet d'accéder à l'intelligibilité d'un monde qui justement n'est pas régi par des lois correspondant aux impressions dictées par nos intuitions premières, par ces impressions dont justement R. Thom fait si grand cas! Il semble surtout, comme le laisse penser sa description de la p. 129 (il semble que les spécialistes se sont dits: nous avons une théorie qui fonctionne, n'allons pas au-delà et ne cherchons pas à regarder ce qui est donné par le formalisme") que R Thom en soit resté à l'interprétation littérale de l'école de Copenhague, au début du siècle dernier, et ignore complètement les avancées majeures, tant théoriques qu'expérimentales, accomplies depuis (les travaux de Feynman, d'Aspect, par exemple...). En gros, R thom nous apprend que la mécanique quantique ne le convint pas, car elle ne cadre pas avec sa conception du monde... Entre la mécanique quantique et les conceptions de Thom, mon choix (et celui de la réalité!) est fait!.

Dès la p. 91, Il avoue d'ailleurs qu'il "croit que l'expérimentation par elle-même ne peut guère conduire à des progrès", ce qui lui permet de souligner avec raison le manque de théorie globale de la biologie (alors même que la théorie de l'évolution constitue cette charpente idéalisée...). R Thom croit que la pensée prime toujours sur l'expérience, et que c'est l'introspection, l'état mental du chercheur qui est le chemin le plus sur vers la découverte...

P.93, se pose le problème de l'observation: comment reconnaître une chose sans en avoir au préalable un concept ?

P.96, R Thom rejoint les opinions de Gell Mann à propos de l'importance de la détection des régularités en physique.

P 100, se pose LA grande question: les "êtres" mathématiques préexistent-ils à leur découverte ? C'est la cas pour Thom, qui se rallie en fait à l'idéalisme platonicien mâtiné d'Aristotélicisme: "Les idées mathématiques sont produites dans notre cerveau dans la mesure ou nous les pensons. Mais comme elles existent lorsque nous ne les pensons pas, alors elles existent quelque part, et pas seulement dans notre mémoire (...) elles existent ailleurs". Ces idées préexistent d'ailleurs à leur découverte, se réalisant dans tel ou tel cas selon le "matériau" cérébral disponible...

Thom ne considère donc pas les mathématiques comme une création humaine, mais bel et bien comme une manifestation de la réalité perceptible par l'activité mathématique. Reste à définir le lieu d'existence de ces êtres mathématiques !

Dans les pages 102 et 103, nous retrouvons un R Thom complètement perdu au pays de la physique moderne: ni la physique quantique, ni la cosmologie ou la relativité ne trouvent grâce à ses yeux. Leur crime: ne pas correspondre à la réalité macroscopique usuelle, laquelle est seule garante de la vérité (en gros, R Thom croit le monde et ses lois taillées sur mesure pour la perception humaine... et reste échoué sur la physique de Newton comme R Crusoé sur son île...). R. Thom est embarrassé par la description physique du cerveau, dont il aurait bien aimé qu'il reste une boite noire inexplorée : il dénie ainsi toute valeur aux travaux des neurophysiologistes, car ces derniers sont "matérialistes"... (le fait que la pensée soit liée à la matière ne cadre pas, en effet, avec l'idéalisme mathématisant de Thom).

P. 106, relevons une perle se voulant philosophicarde, qui ne déparerait pas dans "le Roland Barthes sans peine": "Le concept d'énergie, à bien des égards, me semble effectivement une sorte de conceptualisation d'une prégnance indifférenciée".

P 115, nous retrouvons l'intrépide Thom en train d'explorer le tube digestif, lequel sert d'illustration aux notions d'intérieur et d'extérieur... R Thom persiste à croire que le tube digestif est intérieur à l'organisme, alors qu'il n'est qu'une interface entre le milieu extérieur (qui traverse l'organisme) et le milieu intérieur. Par contre, le TD est à l'intérieur du corps visible, et c'est la distinction qui échappe à Thom, pour qui cependant l'approche holiste semble si importante...

Il arrive cependant que R Thom présente de brillantes analyses et des idées très intéressantes. Ainsi, déplorant la faiblesse théorique de la biologie (selon lui), il mentionne avec justesse que " il n'y a de science que dans la mesure où l'on plonge le réel dans un virtuel contrôlé".

Thom conclut son ouvrage par un prêchi-prêcha écolo du meilleur aloi, sur le thème d'une nécessaire "croissance zéro", et l'éloge des sociétés primitives "qui ne gâtaient pas leur environnement" etc... Il ne manque que J’ J’ Rousseau, on croirait lire ici le mensuel "l'écologiste". Quant à la "bonne" idée de "refroidir l'humanité", terme emprunté à Levi Strauss, son application pratique laisse augurer des pires totalitarismes...

On est frappé, au final, par l'archaïsme de certaines conceptions, comme celles de la forme prépondérante des réseaux neuronaux permettant l'incarnation des idées mathématiques provenant d'un ailleurs indéfinie, et par l'entêtement à lutter contre l'expérience et contre toute construction mentale qui en viendrait à ne présenter l'apparence des choses que comme un avatar provenant de notre échelle de perception, que ce soit au niveau spatial ou temporel. Bien qu'on puisse tout à fait souscrire à l'idée selon laquelle une approche qualitative des phénomènes puisse avoir une valeur explicative supérieure à une approche purement analytique, les illustrations choisies par l'auteur semblent fort mal choisies, et une actualisation de ses connaissances dans les domaines qu'il flétrit injustement lui retirerait la plupart de ses arguments...

A lire cependant pour l'approche plus qu'originale de l'auteur, l'esprit ouvert et le sens critique aiguisé !

N. Witkowski - Une histoire sentimentale des sciences

Ce petit livre est un vrai bonheur : N Witkowski y raconte les aventures d'une trentaine de scientifiques, connus ou oubliés, célèbres ou, c'est plus courant, écrasés par le poids de leurs découvertes au point, dans les hagiographies scolaires (si il en reste, tant l'histoire des sciences est absente de l'enseignement). Défilent ici nombre de célébrités présentées sous leur tour le plus humain, faillible, avec leur découverte située dans le contexte et l'histoire des idées de l'époque.

L'histoire de Spallanzani, par exemple, éclaire d'un jour nouveau la défiance "actuelle" envers les sciences.

Ce livre est un remède salutaire à tous ceux qui jugent que la démarche scientifique est une attitude rigide et logique apte à être théorisée et enseignée. A ceux dont les conceptions vident les amphis, l'histoire (et même la petite histoire) apporte un cinglant démenti.

A lire de toute urgence !

B Greene - l'Univers élégant (la chasse aux infinis, je dirais plutôt)

page de l'auteur

Attention, là c'est un ouvrage d'importance visant à présenter l'état actuel de la physique des particules au travers de ses théories les plus complexes, à savoir les supercordes.

L'ouvrage lui-même se compose de trois parties:

- une vulgarisation brillante des conceptions théoriques et des vérifications pratiques de la mécanique quantique et de la relativité restreinte et générale

- une présentation de l'évolution des théories des supercordes, situées dans leur contexte historique et présentant correctement les énormes difficultés et les doutes liés à cette approche.

- un ensemble de notes visant à préciser quelques points, principalement à l'attention des lecteurs disposant déjà d'une formation scientifique et désireux d'aller plus loin "sous la surface des choses".

Je ne résiste pas à citer, ainsi, la définition d'un "Calabi-Yau": "une vraie tranche tridimensionnelle de l'hypersurface de degré 5 du 4 espace projectif complexe" (p 623). Voilà de quoi briller en société (ou, plus probablement, passer pour un...)

L'ouvrage est bien construit, bien écrit, et comporte de fréquents rappels bienvenus, car les livres de cette envergure sont rarement lus d'une traite!

Rappelons l'idée centrale des théories des supercordes: le zoo des particules élémentaires n'est qu'une apparence, les particules ne sont pas ponctuelles, mais constituées de minuscules cordes vibrantes dans des espaces multidimensionnels, dont chaque mode de vibration engendre une particule et ses propriétés (Pour une présentation imagée, la société NOVA, qui a produit le documentaire "l'univers élégant" permet d'en visionner l'intégralité sur son site)

Historiquement, tout à commencé en 1968, lorsque G Venazianno a découvert que la fonction gamma de Euler, découverte 200 ans plus tôt, décrivait parfaitement l'interaction forte. Par la suite, L. Suskin mit en évidence que cette description impliquait que les particules en jeu n'étaient pas ponctuelles, mais allongées, en forme de cordes vibrantes...

Gros avantage des cordes: leur extension spatiale, car comme le remarque Greene p. 253: "Si les constituants élémentaires de l'univers eux-même ne permettent pas de sonder les distances inférieures à la longueur de Planck, alors ni eux ni rien d'autre ne sera jamais affecté par les prétendues désastreuses ondulations quantiques qui règnent à cette échelle". Les cordes limitent la "granularité" du monde, et évitent ainsi que ne surgissent les grandeurs infinies qui caractérisent les particules ponctuelles.

Cette idée que les dimensions physiques, matérielles, sont supérieures à 3 n'est pas nouvelle: elle a été avancée dès 1919 par Theodor Kaluza, mathématicien polonais en avance sur son temps... (p.298). Comme mentionné p. 314, Kaluza a remarqué qu'en introduisant une dimension spatiale supplémentaire, il parvenait à unifier la gravitation et l'électromagnétisme (ce qui me fait penser que l'on peut fort bien analyser l'électromagnétisme comme une dimension supplémentaire, et non une force). Malheureusement, les premières idées de Kaluza sur cette unification n'ont pas été confirmées par l'expérience. En fait, cela signifie seulement qu'envisager une seule dimension supplémentaire ne suffit pas ! (accessoirement, cela montre aussi qu'une belle idée, esthétique et unificatrice, n'est pas pour autant la vérité. Or, une bonne partie de la théorie des cordes procède d'une telle conception !).

Tout le chapitre sur ces dimensions cachées est excellent, et il ouvre bien des débats. Ainsi, (p.325), sont mises en évidence 9 dimensions enroulées microscopiques s'ajoutant aux 3 spatiales que nous connaissons. Mais on pourrait fort bien imaginer une dimension spatiale supplémentaire, mais extrêmement grande...

Ces dimensions supplémentaires sont à la racine des supercordes: en effet (p.328): "la géométrie des dimensions supplémentaires détermine les attributs de la physique fondamentale, comme les masses ou les charges des particules que l'on observe dans les trois dimensions habituelles."

la p 584 nous offre un bon résumé de l'approche "cordiste" que je retravaille un peu ci-dessous :

"Einstein a découvert que l'espace et le temps étaient inextricablement liés par le fait inattendu que le mouvement d'un objet dans l'espace influe sur son évolution dans le temps. La relativité générale montre que la forme particulière de la structure spatio-temporelle transmet la force gravitationnelle d'un point à un autre. Les fluctuations quantiques violentes du monde microscopique montraient qu'une théorie nouvelle était nécessaire, ce qui conduit à la théorie des cordes, qui impose que l'univers possède plus de dimensions que celles qui sont visibles. Certaines d'entre elles seraient entortillées dans des formes minuscules, mais très compliquées, pouvant subir des transformations extraordinaires, où leur structure est percée et déchirée puis se répare finalement d'elle-même."

Cordes et critiques

Greene ne cache pas dans on livre que les bases expérimentales de la théorie des supercordes sont quasiment inexistantes. Bien que Witten puisse dire que la gravitation découle des supercordes, force est de constater que la théorie de la gravitation a précédé celle des supercordes... Il fait là preuve d'un raisonnement circulaire.

Greene l'avoue sans faux semblants (p.335): "la TC est-elle correcte ? Nous n'en savons rien."

Les critiques pleuvent sur cette théorie, surtout dans les années 80:

- S Glashow et P Ginsparg :" les théoriciens des supercordes poursuivent une harmonie interne ou élégance, unicité et esthétisme définissent la vérité... Coïncidences magiques, annulations miraculeuses et relations entre domaines sans rapport, et même inconnus, des mathématiques... Les mathématiques et l'esthétique supplantent elles et transcendent elles vraiment l'expérience ? ... Cette théorie est soit parfaitement exacte, soit totalement fausse."

Citons aussi R Feynman, pour qui il doit exister d'autres manières de se débarrasser des infinis gênants en physique...

Depuis cette époque, Greene remarque que les critiques sont moins nombreuses, et attribue cela à la fois à la plus grande modestie des théoriciens des SC et au manque de progrès des autres voies de la physique. On pourrait aussi rajouter que, depuis les années 80, de nombreux étudiants de physique "formatés" aux SC sont sortis des labos et ont commencé leur carrière tout pénétrés de l'esprit des théories cordistes...

Greene suit en fait l'avis de D , pour qui c'est la façon de faire de la physique qui change, les théoriciens n'étant plus, comme par le passé, à la remorque des expérimentateurs, mais dans la situation bien plus inconfortable d'ouvrir seul les voie vers la vérité...

Toutefois, Greene le confesse facilement (p.441): "rien ne nous assure que l'Univers soit construit avec autant de rigueur"

Il est même des critiques plus actuelles:

- Duff (Professeur de physique University of Michigan, Director of the Michigan Center for Theoretical Physics.)" is this just fancy mathematics or is it describing the real world ?" (est-ce seulement de jolies maths ou une description du monde réel ?"

- S. James Gates, Jr. (expert en particules super-symetriques, prof de physique dans les plus grandes universités US (MIT, Caltech, Harvard...) "is it there in the laboratory ? Can you find its evidence ?" (Ou peut on démontrer expérimentalement tout cela ? Peut-on trouver des preuves ?)

-Joseph Lykken ( Fermi National Accelerator Laboratory (Fermilab), prof de physique à l'université de Chicago): How do you actually test string theory? if you can't test it in the way that we test normal theories, it's not science, it's philosophy. (Peut-on tester les théories des cordes ? Si on ne peut le faire, comme pour toutes les autres théories, alors ce n'est pas de la science, mais de la philosophie."

Plus récemment (Mai 2005), Philip W Anderson, de l'université de Princeton, Prix Nobel, n'a pas craint d'affirmer : "Est-ce que la théorie des cordes est un exercice futile, en tant que recherche censée appartenir à la physique ? Je pense que c'est le cas. C'est une spécialité intéressante des mathématiques qui a déjà produit des éléments utiles et en produira d'autres dans le futur. Mais ce domaine ne semble pas plus intéressant en mathématiques que bien d'autres et ne justifie nullement les efforts incroyables qui sont déployés dans cette direction.

Mon opinion est que la théorie des cordes est la première théorie, depuis des siècles, à être développée à l'inverse des principes édictés par Bacon, c'est à dire sans suivre le moindre fil conducteur de nature expérimentale. C'est une façon de décrire la Nature telle que nous voudrions qu'elle soit et non telle qu'elle nous apparaît et t il est peu probable que la Nature pense de la façon nous nous le faisons actuellement.

Ce qu'il y a de triste, comme me l'ont dit des jeunes ayant envie de devenir physiciens théoriciens, c'est que cette discipline est si développée maintenant que c'est devenu un travail à plein temps de simplement suivre comme elle poursuit son chemin. Cela signifie que d'autres directions de recherche ne seront pas explorées par des jeunes, talentueux et imaginatifs et qu'il n'y a nulle autre façon de faire carrière qu'en acceptant de suivre cette unique voie. Les autres chemins sont simplement bloqués. "

Sur le signe de Witten.

p. 294, les propos de Witten, sur la surabondance de théories des supercordes (5): "si l'une des 5 théories décrit notre univers, qui donc habite les 4 autres ?" sont un prélude à la découverte que les 5 théories peuvent constituer, en fait, 5 variantes d'une seule théorie des supercordes, la très hypothétique "M" théorie...

P484-485, on découvre que la théorie des supercordes devrait plutôt être appelée théorie des supermembranes, et on se demande même si ces objets ne se déploient pas dans d'autres dimensions (491): "la théorie des cordes contient en fait des membranes à 2 dimensions. Ne pourrait-il pas y avoir des objets de plus haute dimension ? A l'heure actuelle, la réponse n'est pas totalement connue." Si ces objets se révélaient avoir une extension supplémentaire, pourraient-ils alors constituer les briques tridimensionnelles de notre réalité sensible ? Existe t'il des "cases de Planck" indivisibles, pleines, construisant le monde comme l'enfant empilant des cubes construit son univers imaginaire ?

Contraction de l'espace

Un des apports théoriques les plus intéressant des cordes est leur capacité à borner les dimensions et les phénomènes aux alentours de la longueur de Planck. Ainsi, même un effondrement gravitationnel en apparence infini n'est plus possible: une fois atteinte la longueur de Planck, la géométrie des cordes stoppe l'effondrement et le remplace par... une expansion !

Tout le chapitre intitulé "géométrie quantique" est à lire et à relire. P. 389, vous aurez l'impression de vous retrouver dans le premier opus du film "Men in Black". Toutefois, la pièce maîtresse est apportée p. 396, avec ce que j'ai appelé le rebond de Planck: toute contraction de matière se trouve stoppée à la longueur de Planck: "On évite ainsi le big crunch jusqu'à une extension nulle puisque le rayon de l'univers tel que le mesure les modes de corde légers, reste toujours supérieur à la longueur de Planck... ce rayon décroît jusqu'à la longueur de Planck puis commence aussitôt à réaugmenter: l'effondrement devient un rebond ". Appliquons le même raisonnement à l'effondrement d'un trou noir...

Les trous noirs, justement possèdent comme uniques caractéristiques masse, rotation et éventuellement une charge. Autrement dit, les trous noirs se caractérisent comme de grosses particules élémentaires (498). Toutefois, l'étude des "effondrements" de l'espace, c'est-à-dire des fameuses dimensions cachées, aboutit à des résultats surprenants (505): lorsqu'une sphère tridimensionnelle s'effondre, la structure dimensionnelle peut se déchirer puis se réparer en rouvrant la sphère (redonnant une expansion) mais ici alors que nous avions n dimensions en effondrement, nous n'en avons plus que (n-1) en expansion ! Ces transitions topologiques de l'espace (dites conifold) montrent qu'un effondrement gravitationnel peut engendrer une modification de la topologie des dimensions enroulées des cordes évitant l'apparition de quantité infinies. Il existe même d'autres effets encore plus inattendus (513): "une fois que la sphère s'est trouvée réduite en un point, le trou noir se retrouve dénué de masse - bien que cela semble loufoque et mystérieux.".

A ce propos, P 522, Greene présente et utilise les travaux de Hawking sur le rayonnement des trous noirs et leur évaporation. Toutefois, ces travaux sont basés sur les particules virtuelles surgissant de la mousse quantique.... Mais celle-ci existe t' elle dans la théorie des cordes ?

Entropie d'un trou noir et supercordes

Comme Bekenstein le supposait et Hawking l'a vérifié, les trous noirs possèdent une entropie, qui peut être identifiée à l'aire de leur horizon. Cette entropie est colossale, mais que représente t'elle? Une réponse est apportée par la théorie des cordes, mais elle considère des trous noirs très particuliers dits extrémals.

Toutefois, ils ont réussi à montrer ici l'identité entre l'entropie mesurable par le rayonnement du trou noir, et l'entropie calculable à partir des SC.

Que devient l'information tombant dans un trou noir ? Est-elle irrémédiablement perdue, accroissant ainsi l'indétermination globale de l'univers d'une quantité supplémentaire à celle générée par le principe d'incertitude ? Ou bien peut-elle resurgir du néant lorsque le trou noir s'évapore, son horizon diminuant ? Personne ne sait, pour le moment, ce qu'il en est (Hawking et Thorne militent en faveur de la perte, Preskill, utilisant les SC, pense que la restitution est possible...).

Ce n'est pas là un mince problème, car comme le déclare Hawking (532):" la plupart des physiciens veulent croire que l'information n'est pas perdue (...) on doit accepter l'éventualité que l'espace-temps se noue lui même et que l'information se perde dans ses replis. La question de savoir si oui ou non il y perte d'information est l'une des principales questions de la physique théorique."

Et si les trous noirs étaient liés au problème de la flèche du temps, cette perte d'info la définissant? Et s’ils étaient des convertisseurs d'espace en temps ?

Une autre de mes réflexions s'est trouvée confortée à la p. 573, où Greene nous apprend que Lee Smolin a proposé que chaque trou noir constitue "la semence d'un univers nouveau" (j'avais eu la même idée, confusément). Ces univers "demeureraient à jamais cachés par l'horizon du trou noir". L'avancée principale de Smolin tient à ce qu'il devient alors possible d'invoquer un mécanisme de sélection naturelle pour aboutir à des univers dont les paramètres sont optimaux pour la formation de trous noirs, ce qui permet d'esquiver les redoutables (pour qui ? Greene semble en faire grand cas, mais ce sont souvent des tautologies) pièges des principes anthropiques...)

La formulation des supercordes conduit à l'existence d'une symétrie spatiale par rapport à la longueur de Planck: tout événement au-delà de cette longueur peut être relié à un événement identique en deçà de cette longueur, les deux étant indiscernables...

Cette symétrie se manifeste au niveau du big bang: en remontant le temps (p.555) "la température atteint un maximum (à la longueur de Planck) puis commence à décroître.".

Recherche de confirmations:

Si les supercordes sont super, justement, c'est qu'elles prédisent l'existence, pour toute particule, d'un partenaire plus lourd, dit supersymétrique. Si l'un de ces partenaires venait à être détecté, la réalité des cordes s'en trouverait renforcée.

Il faut toutefois attendre la page 559 pour découvrir ce que je considère comme le meilleur argument en faveur des SC: ces dernières expliquent de façon extrêmement convaincante la phase inflationnaire du big bang: "plus (les 3 grandes dimensions spatiales) elles se dilatent, plus il est improbable que d'autres cordes les entourent, puisqu'il faut d'autant plus d'énergie à la corde pour envelopper une dimension plus grande. Ainsi, l'expansion se nourrit d'elle-même, de moins en moins contrainte à mesure que les dimensions grandissent.".

On doit aussi remarquer que les SC fournissent des explications convaincantes pour origine de la gravité (si le graviton existe!), le pourquoi des 3 familles de particules et l'origine de la masse...

La lecture de l'ouvrage de Greene permet de poser de fascinantes questions :

Il pourrait exister des particules à charge électrique fractionnaire (autre que les quarks 1/3 et 2/3), leur détection confirmerait les théories SC.

P. 374, l'enroulement des cordes autour des dimensions microscopiques refermées sur elles-mêmes me fait me demander si l'omniprésence de pi dans la physique n'est pas le signe de l'existence de dimensions cachées "sphériques"...

p 594, la géométrisation de la théorie quantique apparaît comme une voie où "espace, temps et propriétés quantiques seront réunis et inséparables". Pythagore aurait-il eu raison ? Tout serait nombre, ou plus exactement tout serait forme.

p. 588 se pose la question de voir "la théorie créer sa propre scène spatio-temporelle à partie d'une configuration dénuée de temps et d'espace". Ainsi, se pourrait-il qu'en fin de compte, temps et espace ne soient que le résultat, ou même directement, d'un calcul? Nous pourrions établir ici un parallèle avec l'approche défendue par S Wolfram...

p 599, une grande question: existe t'il une limite à l'explication scientifique du monde ? "Peut-être nous faut-il accepter, après avoir atteint le niveau de compréhension le plus fondamental que la science puisse offrir, que certains aspects de l'univers restent tout de même inexpliqués". En fait, cette interrogation est causée par l'examen des conditions initiales de l'univers lui-même : comment ont-elles été déterminées ? N'habitons-nous qu'un seul univers parmi tous les possibles, ou le seul où la conscience ait pu prendre son envol ?

Là, Greene en profite pour placer la notion de "choix divin", ou utilise, de temps à autre, le terme de "création" pour l'univers. Je crois qu'il ne faut voir là que l'héritage de sa culture nord-américaine, imprégnée de références religieuses, plus qu'un dessein volontaire ou un point de vue théologique ou prosélyte.

En résumé, un ouvrage éclairant, qui mérite d'être lu entièrement, puis approfondi chapitre par chapitre, et dont les références, si on voulait les examiner de façon sérieuse, suffiraient à occuper une vie.

C'est aussi un merveilleux roman décrivant la quête de la connaissance entamée, voici des siècles, par les premiers scientifique et qui, ici, amène aux interrogations les plus hautes et aux découvertes les plus stupéfiantes sur cet étrange univers que nous avons fait notre...

B Greene - La magie du Cosmos (L'Univers élégant 2 le retour de la vengeance). Ed Robert Laffont, 665 pages de la mort-qui-tue

Le deuxième tome des aventures de Greene au pays des cordes est un délice de gourmet: on peut le déguster lentement, par chapitres, ou passer quelques jours plongés dans sa lecture, à se nourrir de chips et de coca. À côté des possibilités offertes par la théorie des cordes appliquées à la recherche de la structure de l'espace, le seigneur des anneaux devient une aimable bluette comparable, comme dirait l'autre, à un playmobil dans un évier.

Je craignais de me retrouver avec ce livre en possession d'une simple version réactualisée de l'univers élégant, mais ce n'est pas le cas: le sujet du bouquin est des plus fondamental: qu'est-ce que l'espace? Qu'est-ce que le temps ? Quelle est la structure intime de l'espace-temps ? Quelle est la nature physique du phénomène que nous appelons réalité ? Et pourquoi existe'il, manifestement, une direction dans l'écoulement du temps ?

Dans une première partie, Greene résume les apports de la physique classique, puis moderne, à ces questions. Bien que certains exemples reprennent les explications du livre précédent, ils sont ici traités dans une autre optique: le problème de l'origine, de la structure de l'espace-temps. L'approche n'est donc pas la même, mais on en a pour son argent. Les perspectives historiques sont bien décrites, l'écriture agréable. Greene, selon son habitude, a regroupé en fin d'ouvrage un gros paquet de "notes" de niveau variable (la plupart destinées aux "professionnels de la profession") mais d'un grand intérêt pour l'esprit curieux (y en a t'il d'autres ici ?). C'est un peu agaçant, car si l'on veut s'y référer la lecture devient vite hachée par ces références. Elles ne sont pas, toutefois, indispensables à la compréhension de l'ensemble. Personnellement, j'ai collé sur les pages de notes un signet mobile, genre post-it, qui me permettait de m'y référer aisément.

Bien entendu, Greene se base, dans une seconde partie, sur la théorie des supercordes (décrite rapidement, le détail étant donné dans son précédent ouvrage) pour pénétrer au coeur de l'espace-temps. Honnête, il précise bien que, pour le moment, cette approche n'est que théorique, mais donne des pistes pouvant conduire à une vérification expérimentale prochaine (avec beaucoup de chance) des assertions cordistes. En particulier, l'entrée en fonction du LHC devrait permettre de détecter les premières particules supersymétriques.

Examinons un peu plus en détail les "temps forts" de l'ouvrage:

p. 212 "l'ordre actuel est un vestige cosmologique" : Greene donne une explication claire sur les implications du second principe de la thermodynamique, et montre qu'un univers primordial, soumis à la gravitation, constitué d'un gaz uniformément (presque....) réparti possède une entropie extrêmement basse, correspondant à un état hautement ordonné. L'évolution ultérieure de l'univers découle largement de cet ordre initial qui n'a de cesse de diminuer, la constitution locale d'entités ordonnées (étoiles, planètes, êtres vivants...) étant largement compensée par l'élévation globale de l'entropie universelle... Notre seule existence, en tant que structure de très basse entropie, est un fait cosmologique majeur!

p. 216: Il découle de qui précède que le big bang lui-même correspond à la structure la plus ordonnée possible de notre univers. C'est une des sources de la flèche du temps qui "a pris son envol dans l'état hautement ordonné, de très basse entropie, de l'univers des premiers instants". Toutefois, cette explication de l'existence du temps, limitée à la physique classique, n'est pas suffisante. Il faudra la compléter par la suite, par les fantastiques possibilités offertes par le monde quantique..

p. 224: Nous retrouvons le problème permanent, sphérique même, de la nature de la réalité quantique. Il s'agit ici de "l'intégrale des chemins" de Feynman. Un électron (ou un photon) emprunte t'il vraiment, réellement, tous les chemins entre deux points où bien ne s'agit il là que d'un artifice mathématique? Question ouverte, dont la réponse dépend en fait de ce que nous appelons réalité. La physique quantique et toutes les expériences et mesures nous crient qu'effectivement le photon emprunte tous les chemins possibles entre deux points, et notre cerveau nous hurle que cela n'est pas possible! Il se trouve tout simplement que les électrons n'ont cure de nos perceptions sensorielles. Comme le mentionne Greene "l'efficacité de la mécanique quantique est des plus étonnantes: elle explique ce que l'on observe, mais ne permet pas d'observer ce qu'elle explique" (225). La sommation de tous les possibles est LA réalité de la particule: "n'importe quel choix que pourrait faire un objet pour aller d'ici à là est inclus dans la probabilité quantique associée à l'un ou l'autre résultat" (226).

p.241: la non-localité. Greene montre bien, à partie d'expériences basées sur le paradoxe EPR que la physique quantique obéit à un principe de non-localité dans l'espace (plus exactement dans l'espace-temps). Il se base sur des expériences variées, et en particulier sur celle réalisée par Kim & al. (Physical review letters 84, 1-1-2005) montrant clairement (c'est lumineux!) que le "parcours" des photons ne peut être décrit en terme locaux: les photons empruntent bel et bien plusieurs chemins à a fois.

p. 250 nous sont rappelées les différentes conceptions de la mécanique quantique: celle d'Heisenberg, selon lequel les fonctions d'onde ne sont que ce que nous pouvons connaître de la réalité (et pas la réalité elle-même), celle d'Everett pour laquelle toutes les éventualités se produisent simultanément dans autant de mondes différents (univers multiples), celle de Bhom pour qui particule et fonction d'onde sont deux aspects différents d'une même réalité cachée (et non pas de variables cachées), et ce, de façon non locale, celle de Ghirardi et ses amis selon lesquels les fonctions d'onde sont intrinsèquement instables et s'effondrent une fois par milliard d'années (ce qui permet aux objets macroscopiques, conglomérats de plusieurs milliards de fonctions, d'adopter spontanément un comportement classique)... De quoi faire son choix.

p. 298, une très importante mise au point porte sur l'idée de simultanéité à l'échelle universelle. L'auteur montre que les descriptions de l'univers sont en fait des simplifications à t constant, mais que pour des observateurs en mouvement un "maintenant" peut correspondre, selon le cas, avec notre passé ou notre futur.

P. 321 intervient l'étoile montante de la physique, le boson de Higgs. On y apprend que c'est l'existence du champ de Higgs qui explique la différence actuelle entre électromagnétisme et force nucléaire faible. Ce champ de Higgs possède une importance fondamentale, car dès la page 340 nous voyons qu'il serrait responsable de l'inflation, ce "gonflement" super-rapide de l'univers primordial, par le biais d'un champ de Higgs nommé l'inflaton (voir la partie "astrophysique" du site pour plus de détails). Toutefois, Greene décrit bien les différences entre la constante cosmologique (constante...) et le champ de Higgs (dont la valeur est variable). La description de l'inflation donnée est remarquable de simplicité (contant les mésaventures d'une grenouille dans un moule à gâteaux) pour un phénomène à l'abord si complexe!

p. 386: En une page, Greene récapitule les 386 précédentes en se focalisant sur le problème de la flèche du temps. Comme vous m'avez lu jusqu'ici, autant vous faire profiter en quelques lignes de ce que l'on peut en tirer (c'est du résumé de résumé, du concentré donc...): "Dans un état primordial chaotique très ordinaire, de très haute entropie, une fluctuation statistique, probable et aléatoire, a permis à un "morceau" d'espace de 10 Kg de subir un inflation. Cette expansion fulgurante a étiré l'espace au point que celui-ci n'a plus qu'une faible courbure. Vers la fin de l'expansion, l'inflaton transféra son énergie, amplifiée, à de la matière et du rayonnement qui emplirent presque uniformément l'espace. L'influence "dispersive" de l'inflaton diminuant, la gravité usuelle, attractive, pris le dessus et les petites hétérogénéités découlant, à l'origine, de l'agitation quantique, servirent de germe à la croissance des galaxies..."

Et le rapport avec l'écoulement du temps ? " C'est la nature uniforme, hautement ordonnée et faiblement entropique de la structure spatiotemporelle induite par l'expansion inflationnaire qui amorça l'évolution de l'univers vers une entropie toujours croissante et fournit donc la flèche du temps dont nous faisons l'expérience."... Une précision importante est mentionnée dans une note (640). Greene est honnête, car elle découle d'une théorie concurrente des supercordes (oui, cela existe): la gravité quantique à boucle. Lorsque l'on formule les théories classiques et termes quantiques (équations de Wheeler et De Witt) la variable temps disparaît. Dès lors se pose une question: le temps ne serait-il qu'un concept dérivé d'une autre grandeur physique ?

p. 405 Greene nous donne une excellente définition de l'activité scientifique: "Connaissances solides, aisance mathématique, souplesse d'esprit, ouverture à toute connexion inattendue, immersion totale dans le flot des idées de la communauté internationale, travail acharné et bonne étoile"

P. 469 et 470, une précision importante est donnée sur les dimensions supplémentaires nécessitées par les supercordes. Bien que la version la plus populaire de cette théorie fasse appel à des dimensions sub-microscopiques refermées sur elles-mêmes, Greene présente les théories mettant en jeu des branes (objets bi-dimensionnels auxquels sont liés les cordes unidimensionnelles). Si notre univers était une "3-brane" (support de corde à 3 dimensions d'espace) alors les dimensions supplémentaires indispensables aux cordes peuvent être très grandes, aussi étendues que nos dimensions usuelles... mais nous ne pourrons jamais (hum) les détecter... (Problème récurrent chez les supercordistes). Signalons aussi une coquille p. 471: l'attraction entre 2 corps diminue lorsque leur distance augmente !

p. 473, Greene présente une explication, qui devrait être enseignée dès le début des études de sciences, sur les lois en 1/d2 et leur implication sur la courbure de l'espace. De telles explications permettraient de souligner le sens physique de ce qui, pour les étudiants et élèves, n'est souvent qu'une collection de formules sans lien avec le réel.

P 491, Greene nous fait un aveu: les aventures des branes qu'il nous a contées ne sont pas vraiment sa tasse de thé: "ces scénarios (brane et cosmologie branaire cyclique) sont très spéculatifs. Si je les ai présentés ici, ce n'est pas tant parce que j'ai la conviction qu'ils sont corrects, mais surtout pour montrer comment la théorie M inspire des manières radicalement différentes de penser". En gros, ces théories font travailler l'imagination, mais quel est leur lien avec la réalité ? Ou, plus prosaïquement, ces théories sont-elles pensées ou rêvées ?

p. 538, Un point très important est précisé sur la structure du temps: "maintenant" n'existe pas en tant que singularité temporelle. Chaque instant existe en même "temps" que tous les autres. Ils ne peuvent changer (étonnant et contraire à notre intuition): passé, présents et futur sont, tout simplement, comme des points définis dans l'espace-temps. Il n'existe pas de paradoxes temporels liés à la modification du passé: "si l'on remonte le temps vers le passé, nous faisons, ferons et avons toujours fait partie du passé, ce même passé qui nous a conduits à voyager jusqu'à lui." Les pages suivantes permettent à l'auteur de compléter ce point de vue, en notant par exemple le problème du libre arbitre et la possibilité d'univers parallèles (d'espaces-temps différents). Un voyage dans le temps reviendrait alors à un changement d'univers... On peut tout simplement se dire que ces voyages temporels sont scientifiquement impossibles, mais (p. 547) Greene précise bien que "personne n'a montré que les lois de la physique excluaient la possibilité de remonter dans le temps".

P 551, nous voici embarqué dans "stargate": Greene nous décrit un "trou de vers" macroscopique (ce qui est sans doute impossible) et mentionne que, du fait du statut du trou, même le déplacement d'une de ses extrémités n'altère en rien le caractère connexe de ses deux extrémités: même si l'extrémité d'un trou se déplace, on se retrouve toujours à dimension (l,t) constante ! (les photons sont, en quelque sorte, les trous de vers de l'univers: ils relient n'importe quel point de l'univers de façon instantanée... dans leur temps propre!)

p. 568, sans s'en douter, Greene jette une ombre sur les cordes: il existe 5 versions des théories cordistes, et un observateur décrivant l'univers avec l'une d'elle obtient une description de l'univers qui ne concorde pas avec un autre observateur utilisant une autre version de la théorie. Ces deux observateurs faisant parti du même univers, Greene voit là un indice de ce que l'espace-temps n'est pas "fondamental" mais découle du comportement sensible d'entités encore inconnues. Une mauvaise langue pourrait proposer une autre voie: plutôt que de vouloir tordre l'univers pour le faire entrer dans le cadre cordiste, on pourrait y voir aussi la marque que cette approche est à reconsidérer.

P 570, nous apprenons qu'un trou noir peut être décrit comme étant une région de maximum entropique: "l'entropie maximale que l'on peut accumuler dans une région de l'espace donnée est égale à l'entropie contenue dans un tour noir de même taille que la région considérée". On y apprend d'ailleurs que l'entropie maximale d'une région de l'univers n'est pas reliable à son volume, mais à son aire. Greene en vient à considérer des entités élémentaires d'espace-temps de la taille de Planck. Ceux qui me lisent depuis quelque temps seront familiers de cette idée, puisque je l'ai présentée en 1997, soit 6 ans avant que Bekenstein et Hawking n'y aboutissent (attention, pas de chevilles qui enflent: je n'ai fait que décrire confusément cette idée, le damier de Planck, qui me paraissait logique, mais je n'ai pas les compétences pour étudier sérieusement la question comme l'on fait ces deux grands physiciens... mais je suis content d'y avoir pensé!)

p. 588, A quelques lignes de la fin de l'ouvrage, quelques mots qui montrent que Greene prend bien en compte le manque d'observations en faveur des cordes " Tant que nos théories ne seront pas en contact avec les phénomènes observables, testables, elles resteront dans l'ombre - n'étant qu'une collection d'idées prometteuses qui auront quelque chose à voir avec le monde réel ou pas." Sur ce point, et même si cette confession est tardive, l'honnêteté intellectuelle de Greene est indubitable (contrairement à ce que racontent nombre de ses détracteurs).

Questions ouvertes:

P 548, L'auteur mentionne qu'un univers en rotation serait en lui même une machine temporelle (il veut illustrer les effets d'entraînement de l'espace-temps par des masses importantes en rotation). Et si notre univers était justement en "rotation" (dans quoi?), est-ce que ce ne pourrait pas être l'origine de la flèche du temps ?

p. 616, une note sur l'approche de D Alberts qui propose d'utiliser (dans "Time and chance") une méthode de calcul cosmologique qui me semble être le pendant des intégrales de chemin de Feynman: on élimine ainsi toutes les "chemins" de l'évolution de l'univers incompatible avec un passé de faible entropie qui devient ainsi une condition initiale dont le "pourquoi" reste alors à établir, mais plus a exprimer dans un cadre probabiliste.

P 646, Un fait important et généralement passé sous silence concerne la courbure du temps au voisinage des astres massifs. Contrairement à une opinion répandue, le temps est davantage courbé que l'espace. Ceci est valable même pour un objet de taille stellaire, et bien qu'on ne puisse le représenter graphiquement, dans la majorité des cas, en astrophysique, la courbure temporelle (l'horloge se rapprochant d'un objet massif ralentit) est bien plus importante que la courbure de l'espace...

P 647 se pose l'épineux problème de la conservation de l'énergie dans un espace-temps dynamique. C'est une notion qui intéressera surtout les experts, mais pour les aficionados de la physique il suffit de dire que cette conservation, un principe fondamental, n'est complète que sur des échelles d'espace-temps très petites (tout simplement parce que la gravitation, encore elle, n'est pas concernée par l'expression de cette conservation en relativité générale.

En conclusion, un excellent ouvrage qui nous entraîne à travers les infinis, dans la quête perpétuelle de (certain)s humains vers la connaissance des mystères de l'origine... Un must

B Teyssèdre - La vie invisible - les 3 premiers milliards d'années de l'histoire de la vie sur Terre

La misère de l'édition scientifique française est telle qu'il aura fallu attendre que le philosophe B Teyssèdre (qui se consacre à l'étude de l'esthétique, des représentations des démons, des manuscrits Francs du VIII éme siècle et des débats sur le coloris au siècle de Louis XIV), spécialiste autodidacte et très érudit des origines de la vie, écrive ce livre chez un éditeur improbable dans une collection sur "l'art et les sciences de l'art" (!) pour disposer dans notre langue d'une somme remarquable décrivant les 3 premiers milliards de l'histoire de la vie terrestre, c'est-à-dire la plus grande partie de l'histoire des êtres vivants de notre planète... Attention, ici on ne se pose pas la question des origines de la vie: le livre commence avec les plus anciennes traces de vie connues, et s'achève lorsqu'apparaissent les premiers organismes pluricellulaires, il y a environ 1000 millions d'années...

C'est un ouvrage bien construit et remarquablement écrit, les explications sont claires, mais quelquefois les descriptions sont longues et quelque peu verbeuses: des illustrations, schémas ou photographies, auraient été les bienvenues, mais ne pouvaient s'intégrer, sans doute, dans un ouvrage de ce format (valant tout de même 38 €). Détaillons les aventures des êtres vivants microscopiques, présentés ici dans l'ordre chronologique, le plus logique au vu du sujet traité.

63 - les contributions des isotopes du carbone et la balance 13C/12C comme indice de vie il y a 3800 millions d'années sont présentées de façon extrêmement claire. Le début de l'ouvrage décrit particulièrement bien les controverses opposant les spécialistes des premières traces de vie fossile, et la difficulté d'attribuer à un objet géologique une origine biologique ou minérale.

90 - Mention des expériences de Pierson (1994) qui montrent que le CaCO3 et le FeCl3 des stromatolites fournissent une protection suffisante contre les rayons UV. L'auteur décrit bien un étagement de la photosynthèse avec constitution d'une couche de protection qui filtre les rayonnements et une éventuelle mobilité bactérienne mettant à l'abri les premiers organismes photosynthétiques d'un rayonnement excessif.

92 - Une intéressante description du métabolisme des sulfates, avec une réduction microbienne des sulfates en sulfures avec le carbone organique comme donneur d'électrons, ce métabolisme se déroulant en dessous de 60 °C.

115- Une remarquable description des indices montrant l'absence d'oxygène dans les premières centaines de millions d'années de notre planète. Au cours de l'Archéen, le taux de O2 à su atteindre 1 à 2% du taux actuel, avec une augmentation sensible vers- 2400 MA.

121- L'auteur introduit une remarque extrêmement importante expliquant pourquoi les êtres pluricellulaires ont apparu aussi tard dans l'histoire de la vie. Il relève que les métazoaires nécessitent la présence d'une matrice extracellulaire, d'une charpente de collagènes présente chez tous les animaux. Hors, la synthèse des collagènes réclame un niveau élevé d'oxygène atmosphérique (18 % du PO2 actuel), et ce n'est qu'il y a 1000 MA que ce taux a été atteint dans notre atmosphère, ouvrant ainsi la voie à la pluricellularité...

138 - On apprend qu'il faut 1 MA pour que deux populations séparées d'une même espèce évoluent en 2 espèces distinctes.

153 - On apprend ici que le niveau d'O2 nécessaire à un eucaryote pour effectuer la photosynthèse est très supérieur à celui suffisant à sa respiration. Si on suppose que les chloroplastes dérivent de cyanobactéries, alors il faut attendre que le niveau d'O2 soit de l'ordre de 10% du taux actuel pour que la production de nitrates inorganique soit suffisante pour les ancêtres des chloroplastes, ces derniers étant incapables de fixer l'azote. C'est le taux d'O2 qui conduit, avec les extinctions, la marche de l'évolution. Et comme ce taux est lui même fonction de l'activité biologique, nous avons là un système de coévolution extrêmement intéressant...

162 - Nous faisons la connaissance d'Eosphaera, une bactérie (ou une algue...) sphérique dont la description ressemble à des structures non biologiques observées sur Mars...

180 - Une intéressante question: pourquoi n'observons-nous pas de gros procaryotes ? Parce que de nos jours, des eucaryotes dévoreraient une bactérie trop visible... Nous faisons connaissance avec une bactérie sulfurique géante, thiomargarita, qui possède la taille d'une amibe...

213 - Nous apprenons que des bactéries sulfuriques oxydantes peuvent édifier des stromatolites en eau profonde (30 m). Ces bactéries semblent avoir joué un grand rôle au début de l'histoire de la vie...

218 - L'énigmatique molybdène, rare, mais indispensable aux êtres vivants pour l'assimilation des nitrates, peut expliquer par sa répartition l'abondance de formes de vies dans les zones littorales recevant les alluvions riches en métaux drainées par les cours d'eau continentaux.

224 - Comme souvent, des surprises attendent les paléontologues qui découvrent, progressivement, des organismes évolués dans des sédiments de plus en plus anciens. Ici, ce sont des Acritarches qui datent de plus de 1000 MA.

255 - Plusieurs observations sur la diversité des Acritarches laissent penser que la vitesse de l'évolution est très variable. Une pierre dans le jardin des généticiens qui considèrent, sur de longues périodes, que les vitesses de changement des gènes sont constantes, ce qui apparemment n'est pas le cas.

292 - Nous voici face aux premiers vertébrés, Yunnanozoon et Haikouella. L'auteur y rattache l'énigmatique Diploreuzoa. Il relève avec justesse que la présence de branchies, censée signaler les ancêtres des vertébrés, n'est pas un caractère de diplorozea, mais que c'est aussi le cas pour le célèbre pikaia

302 - Où l'on se demande pourquoi la faune d'Ediacaria a disparu. L'auteur remarque que, dans certains sites fossilifères, les organismes de cette époque sont contemporains de ceux censés les avoir remplacés... Mais le plus important est résumé en bas de page: " Le problème qui avait causé tant de souci à Darwin, la brusque entrée en scène de nombreuses lignées animales, n'est pas résolu. Il s'est plutôt dédoublé. D'un coté l'origine des animaux a été repoussée plus haut dans le temps, d'autres parts les raisons qui ont déclenché l'apparition de la faune cambrienne après celles de Doushantuo et d'Ediacara ne sont que partiellement comprises."

310 - L'auteur remarque à juste titre que la vie est sans doute bien plus vieille que 3800 MA. En effet, les traces de vie détectées à Isua par un déséquilibre isotopique nécessitent un cycle métabolique de Calvin-Benson (photosynthèse) déjà établi. Par conséquent, la lignée conduisant aux cyanobactéries avait déjà, à cette époque, divergé des autres. Ceci illustre la difficulté d'utiliser les apports de la philogénie moléculaire, sujet parfaitement traité dans le chapitre 10 de l'ouvrage, à des époques où les transferts horizontaux de gènes prenaient le pas sur la reproduction des individus.

321- L'auteur présente sur plusieurs tableaux une phylogénie des premiers organismes. Il en ressort que la lignée conduisant aux animaux + champignons s'est séparée très tôt de celle conduisant aux végétaux.

336 - l'auteur ose une hypothèse intéressante: il considère que de nombreux fossiles "inclassables", rangés parmi les algues, sont en réalité des mycétozoaires ou des opisthokontes (comme ces noms ne vous disent rien, disons plutôt qu'ils font parti des ancêtres communs aux animaux et aux champignons.

346 - l'auteur énumère trois éléments génétiques préalables à l'émergence tardive d'animaux fossiles (alors que leur origine phylogénique dépasse 1000 MA, les plus anciens fossiles ont 600 MA): le taux de duplication des gènes de transduction des signaux intercellulaires maximum avant la divergence éponges/autres animaux; la duplication des gènes de l'homéodomaine et la spécialisation de ceux qui contrôlent le développement des tissus entre la divergence porifères/eumétazoaires et cnidaires/bilatéraux et l'établissement de la colinéarité entre les gènes HOX et le développement de l'axe antéropostérieur. Les organismes qui ont connu ces changements ont précédé les animaux, mais la durée de cette évolution est inconnue.

353 - L'auteur apporte plusieurs éléments en faveur d'une évolution a vitesse très hétérogène du génome des eucaryotes. Contrairement à l"hypothèse de départ de la phylogénie moléculaire, il montre bien qu'il n'est pas possible que l'évolution de ce génome se soit déroulée à vitesse constante. Il se situe donc en faveur de la théorie des équilibres ponctués chère à Gould. Comme le dit Teyssèdre : " si la divergence entre les plantes et le clade animaux+champignons remonte à 2200 MA ou plus, et si la divergence entre les eucaryotes et les archea est inférieure ou égale à 3300 MA, il faut que l'évolution du l'ARNr des eucaryotes ait été, depuis l'origine du clade Animaux-champignons-plantes, au moins 20 fois plus rapide qu'auparavant..."

La vitesse de l'évolution semble en effet avoir été très grande au début de l'histoire de la vie, pour décroître ensuite rapidement et atteindre une vitesse constante.

Enfin, à la page 356, l'auteur présente 11 "thèses " (propositions) sur l'histoire de la vie au précambrien. Elles résument un peu cet ouvrage de haute tenu, assez austère, mais bien écrit, qu'on ne peut que chaudement recommander: il est le seul de son espèce en français ! L'ouvrage est complété d'une remarquable chronologie (p 411), d'un index et d'une bibliographie développée de 55 pages.

Au final, on doit remercier l'auteur pour cette remarquable somme d'information mise à disposition du public francophone.

![]()