Astrophysique & physique

nucléaire

"il y a beaucoup plus de choses dans le ciel

et sur la Terre ,Oratio,

que ne peut en rêver

toute ta philosophie" - Shakespeare

C..nneries

quantiques

Un spectre

hante

la physique: la constante cosmologique

Dernière

mise à jour: 28/02/2006

Critique (constructive!) de l'Univers élégant, de Brian Greene.

La

non

séparabilité

quantique implique l'existence de l'atemporalité:

le monde fou du photon, où

la téléportation de Mr Spock théoriquement

possible !

Dans

les années 1930, un ensemble de physiciens de premier ordre

(H Poincaré,

N Bohrs, W. Heisenberg (ci

contre), W.Pauli, A Einstein, les

époux Curie...) cherchant

à expliquer la structure de la matière, ont

créé

la physique quantique, qui gouverne le comportement et décrit

tous les objets à l'échelle moléculaire,

atomique et infra-atomique. Le comportement des particules de

matières ou d'énergie décrit par cette physique

n'est pas intuitif, ne correspond pas du tout à notre perception

macroscopique de la réalité, mais est indubitablement réel, comme de nombreuses expériences l'ont

depuis démontré.Une des conséquences de la

physique quantique est que toute particule est décrite

par une entité mathématique appelée fonction

d'onde. Ors, après une interaction, deux particules

peuvent être décrites par une même fonction

d'onde, même si elles se séparent et se situent

ensuite à plusieurs millions d'années lumière

de distance! Ces particules restent corrélées quelle

que soit la distance qui les sépare. Toute modification de l'état

quantique

d'une particule modifie instantanément l'état de la deuxième particule, ou qu'elle soit dans l'univers! Il

y a donc là le moyen de transmettre une information

(l'état

quantique) instantanément, en s'affranchissant de la notion

de distance.

Dans

les années 1930, un ensemble de physiciens de premier ordre

(H Poincaré,

N Bohrs, W. Heisenberg (ci

contre), W.Pauli, A Einstein, les

époux Curie...) cherchant

à expliquer la structure de la matière, ont

créé

la physique quantique, qui gouverne le comportement et décrit

tous les objets à l'échelle moléculaire,

atomique et infra-atomique. Le comportement des particules de

matières ou d'énergie décrit par cette physique

n'est pas intuitif, ne correspond pas du tout à notre perception

macroscopique de la réalité, mais est indubitablement réel, comme de nombreuses expériences l'ont

depuis démontré.Une des conséquences de la

physique quantique est que toute particule est décrite

par une entité mathématique appelée fonction

d'onde. Ors, après une interaction, deux particules

peuvent être décrites par une même fonction

d'onde, même si elles se séparent et se situent

ensuite à plusieurs millions d'années lumière

de distance! Ces particules restent corrélées quelle

que soit la distance qui les sépare. Toute modification de l'état

quantique

d'une particule modifie instantanément l'état de la deuxième particule, ou qu'elle soit dans l'univers! Il

y a donc là le moyen de transmettre une information

(l'état

quantique) instantanément, en s'affranchissant de la notion

de distance.

Il ne s'agit pas

là d'une vue

de l'esprit: cet effet a été expérimentalement

constaté et confirmé. Tout d'abord par A.Aspect

au début des années 1980, qui a constaté

cet effet sur des photons corrélés séparés

de quelques mètres (soit une distance gigantesque

rapportée à la longueur d'onde des photons!). Depuis, A.

Zeilinger et F Martini ont reproduit

ce phénomène et l'ont étudié sur des

photons plus éloignés. A. Muller, du CEA,

a également constaté cet effet de

"téléportation"

sur d'autres particules que les photons, les mésons K.

Cet effet de

corrélation apporte

un démenti cinglant aux objections d'Einstein sur la physique

quantique: contrairement à ce qu'il avait avancé

avec Podosky et Rosen en 1935, il n'existe pas de "variables

cachés" en physique quantique: le monde quantique

possède bel et bien une indéniable réalité,

même si elle désoriente ceux qui l'abordent!

Réfléchissons:

comment

deux photons peuvent il interagir de façon instantanée?

Personne ne le sait. N'oublions pas que le monde du photon est

très différent du notre: les photons se

déplaçant

à la vitesse de la lumière, le temps n'existe pas

pour eux: leur production est contemporaine de leur mort. Cependant,

il n'en est pas de même pour nous: les photons ayant une

vitesse finie, aucune matière ne peut aller plus vite qu'eux.

La corrélation quantique, qui permet la

téléportation d'information, reste encore un

mystère.

Rêvons un peu: tout corps

matériel

peut être décrit comme une somme de plusieurs fonctions

d'onde, donc toute l'information qu'il contient est susceptible

d'être téléportée instantanément

(Scotty, énergie!).

Quelques remarques personnelles

Il semble que

l'on puisse trouver pas

mal de chose en cherchant une interprétation

géométrique

de la mécanique quantique. Mes compétences actuelles

ne me permettent pas une telle recherche (hélas!) mais

si un jeune physicien me lit, je l'engage à chercher vers

là... Quelques idées en vrac, qui m'ont été

inspirées par la conjonction fortuite entre mes

réflexions

personnelles et certains anciens travaux de JP Petit.

- les particules peuvent être

assimilées à des déformations de la topologie de

l'espace-temps. Une fonction d'onde unique décrit une même

déformation que seules nos perceptions limitées nous

décrivent comme deux photons séparés. L'espace lui

aussi peut être une illusion de nos sens tridimensionnels!

- les interactions entre particules doivent

pouvoir se décrire comme des "rencontres angulaires" : la

déformation d'un substrat peut se décrire en effet en

terme d'onde ou de concentration de courbure (point). Cela ne vous

rappelle rien ? (j'ai eu cette idée, à l'origine, en

remuant un tapi). La courbure, c'est l'existence, le point masse. Le

mouvement, c'est l'onde.

la décohèrence,

passage du comportement quantique au comportement "classique"

Gardons à

l'esprit quelques notions

qui gênent quelque peu cette vision: le comportement quantique

ne s'observe pas sur des objets macroscopiques (vous et moi, par

exemple). Pourquoi? Probablement parce que les fonctions d'onde des particules

interfèrent

entre elles pour se détruire mutuellement: une particule n'étant que rarement

isolée de son environnement, sa fonction d'onde est

modifiée,

réduite par les particules de son environnement: c'est

le phénomène de décohérence

avancé par W.Zurek et M Gell-Mann et expérimentalement

observé par C. Monroe et D Wineland en mai 1996 (National

Institute of Standards and Technology, Colorado) et

étudié

par S. Haroche et JM. Raimond en 1997.

C. Monroe et D

Wineland ont réalisé

un "piège à ion" dans lequel les niveaux

énergétiques

ioniques sont couplés à son mouvement de vibration:

la décohérence est alors qualitativement observée.

S. Haroche, JM. Raimond et M Brune ont utilisés un astucieux

dispositif expérimental dans lequel on observe l'état

quantique de quelques photons piégés. Le passage

à intervalle variable d'atomes de rubidium (à état

de Rydberg* circulaire) dont on détecte l'état quantique

permet de mesurer la vitesse à laquelle les photons

piégés

transitent d'une superposition de

phase à une phase unique.

Cette décohérence se produit en un dix millième

de secondes avec 3 à 6 photons, et ce temps décroît

lorsque le nombre de photons impliqués augmente.

Les objets de

notre environnement comportant

des milliards de particules, leur comportement quantique est soumis

à une décohérence éclair, ce qui rend

inobservable leurs propriétés quantiques...CQFD.

Nous

connaissions, avec le photon, une

particule atemporelle. Faudra il imaginer pour expliciter les

corrélations quantiques, une nouvelle familles d'objets

"aspatiaux" ? (mais, au fait, pour toute particule voyageant

à la vitesse de la lumière, t=0 donc la notion de

distance ne signifie rien, et l'univers propre du photon se

réduit

à... un point

Un passionnant champ de recherche s'ouvre

devant nous. Il est temps d'imaginer.

En avant, direction l'inconnu!

Une citation:

A propos du "principe d'incertitude" de la mécanique

quantique: "L'imprévisible, l'élément

de hasard, n'intervient que lorsque nous essayons d'interpréter

l'onde en termes de positions et de vitesses de particules. Mais

peut être est-ce notre erreur: peut-être n'y a t'il

ni position ni vitesse de particules, seulement des ondes."

- S Hawking "brêve

histoire du temps - ed. J'ai lu, 207

Etat

de Rydberg* circulaire : Etat

d'un atome très excité, ou un électron orbite

très loin du noyau, ici selon une orbite circulaire. Leur

intérêt réside dans leur durée de vie

(longue pour un atome excité) et dans leurs caractères

quantiques qui convergent, à la limite, vers un comportement

classique.

DE

LA TELEPORTATION DES ETATS QUANTIQUES

A CELLE DES OBJETS, PUIS DES

ETRES VIVANTS

Les

avancées réalisées

récemment dans le transfert d'états quantiques (2)

a distance permettent d'envisager sous un jour pratique la

possibilité

de

développer dans le futur la téléportation.

Disons qu'après analyse, rien ne semble l'interdire

sur le plan théorique. La téléportation

peut être envisagée de différentes manières:

- Téléportation par annulation

de distance

- Téléportation par analyse/

transmission / synthèse

Annuler la distance: l'univers dans

son salon

La notion de

distance dépend

de la géométrie dans laquelle on se place: pour

une fourmi se déplaçant sur une bande de tissu,

la distance entre deux point est clairement définie mais

si un coup de vent survient... 2 points disjoints peuvent se retrouver

voisin pendant un bref instant, et notre fourmi peut se retrouver

alors "téléportée" d'un point à

l'autre... Le problème est que notre univers n'est pas

une nappe! Bien que sa géométrie soit sujette aux

déformations causées par de fortes densités

énergétiques (c'est a dire de fortes masses!), celles

ci ne permettent apparemment pas le déplacement d'un objet

matériel sans le détruire. Si il existe

d'hypothétiques

passages reliant des régions éloignées de

l'univers, ils semblent bien concerner prioritairement les particules

élémentaires.... ("ces histoires de distances,

ça ne me concerne pas " signé: un photon)

Faire et défaire, c'est toujours

voyager

Autre

possibilité pour la téléportation:

analyser complètement un objet, transmettre les résultats

de l'analyse et recomposer l'objet plus loin. Comme le fait remarquer

J.P. Delahaye (1) dans un excellent article, c'est déjà

ce que nous faisons avec un fax. On peut parfaitement imaginer

analyser la position et le genre de chacun des atomes d'un être

humain, transmettre les données et le resynthétiser

à l'arrivée. Quelques petits problèmes subsistent,

mais ils ne sont pas insurmontables:

-

l'analyse

doit être la plus complète, mais jusqu'ou? il semble que

la position des atomes suffise, leur état quantique étant

peu important (il est modifié sans conséquence pendant

des examen médicaux tels l'IRM).

-

Le

principe d'incertitude d'Heisenberg n'interdit pas cette analyse: nous

sommes à une température de 37°C, donc nos atomes

sont assez agités et une forte imprécision sur leur

vitesse est acceptable

- La masse d'information a transmettre n'est

pas un obstacle: elle peut être comprimée

-

le

"reconstructeur" est théoriquement possible, puisque l'on peut

déjà déplacer individuellement des atomes (dans

des conditions de températures très restrictives, il est

vrai, et en très petite quantité, mais ce n'est qu'un

début).

Pour ce qui est

du transport d'étres

vivants, la quantité d'information à transmettre

peut être bien plus réduite encore: un être

vivant, c'est un support d'information génétique:

a la limite, la transmission de cette information suffit pour

obtenir un autre être vivant, un "artefact"

génétiquement

identique à l'individu de départ, mais différent

par l'esprit. Ce problème de l'esprit est majeur:

-

si celui

ci ne dépend, comme je le crois, que de la position des atomes a

un instant t, l'individu est téléportable corps et

"âme".

-

Si

l'esprit peut se définir comme un algorithme, un programme

d'ordinateur, alors il est non seulement transmissible mais

également potentiellement immortel: si le corps n'est que le

réceptacle d'un esprit semblable par sa nature à un

"logiciel" (pourquoi pas?), alors ce programme peut être

transféré sur un support moins fragile que le corps

humain...

- Si l'esprit vient d'un "ailleurs" (hum

hum...) alors vivement que l'on fasse l'expérience!

Références:

1 - Logique

& calcul de la téléportation - J.P. Delahaye

- Pour la Science 272-28/34

2 -

La

téléportation quantique - A. Zeilinger - Pour la

Science 272-36/44

3 -

Les

atomes de Rydberg - D. Kleppner, M. Littman, M. Zimmerman - Pour

la Science 45 - 94/109

La

fin du temps....

Quelques visions

sur la fin de l'univers...

Les

derniers résultats disponibles en astrophysique et concernant

la densité moyenne de matière dans l'univers nous

laisse penser que nous vivons dans un univers "ouvert":

depuis le big bang, notre univers croit en taille et devrait continuer

ainsi indéfiniment....

Les

derniers résultats disponibles en astrophysique et concernant

la densité moyenne de matière dans l'univers nous

laisse penser que nous vivons dans un univers "ouvert":

depuis le big bang, notre univers croit en taille et devrait continuer

ainsi indéfiniment....

E Hubble avait découvert cet

effet d'expansion, mais de récents travaux

nous montrent que cette expansion s'accélère (projet

supernova cosmology - S Perlmutter Berkeley lab.). Nous pouvons

donc légitimement faire un choix parmi les modèles

d'univers:

- un univers riche en matière,

fermé, ou l'expansion devrait se ralentir avant de voir le

mouvement s'inverser vers un "big crunch"

- un univers "plat" qui se dilate

uniformément.

- un univers ouvert, contenant "peu" de

matière, ou l'expansion s'accélère

- un univers "mixte" plat mais ouvert,

cadeau de la constante cosmologique!

- un univers "alternatif" dont la topologie

non conventionnelle nous libère de nombre de contradictions

L'univers étant (provisoirement?)

ouvert, voyons

un peu ce qui l'attend dans un futur prodigieusement lointain...

Son destin va dépendre de la stabilité du proton,

constituant de tous les noyaux atomiques.

Si le proton se

désintègre:

prêcher dans le désert...

- année 1024 : l'univers est un immense désert

contenant des trous noirs, des planètes à la

dérive et des étoiles éteintes. La

désintégration du proton "chauffe" les étoiles

à - 240°C. Cette désintégration fournit

d'autres particules: électrons, positons, neutrinos et

antineutrinos qui s'annihilent mutuellement pour donner quelques

photons très énergétiques qui permettent aux

étoiles d'émettre un faible rayonnement infrarouge Petit

a petit, la masse des étoiles diminue donc...

- année 1032: Il n'y a plus d'étoiles

- année 1033: plus de protons. L'univers n'est plus

parcouru que par des électrons, des positons et des neutrinos

qui errent entre des trous noirs et quelques photons...

Si le proton

est stable: les boules

...

- La matière subit

l'effet

tunnel: des barrières énergétiques

infranchissables sont traversées au cour du temps:la structure

de la matière évolue.

- année 1065: toute la matière se comporte comme

un liquide: l'univers n'est plus peuplé que de sphères

lisses

- année 10435: Tous les corps de plus de quelques

millièmes de millimètres se sont transmuté en fer

(cet atome étant le plus stable, celui de plus faible

énergie). L'univers est donc peuplé de boulets de canon

de taille varié, et de particules nombreuses...

- année 10760: Les étoiles de fer se transmutent

en étoiles a neutrons qui finissent par s'effondrer en trous

noirs. Des photons X et des neutrinos sont émis. A la fin, il ne

reste que des débris de fer, des particules et des photons

épars qui finissent un jour par disparaître eux aussi...

Les trous noirs meurent aussi (Si ils existent ;-)

S.Hawking

|

Les

trous noirs eux

même finissent par s'évaporer: à leur

lisière, des particules se forment et en 10100 ans, vident le trou noir de son énergie. Le

trou noir rétrécit, devient de plus en plus chaud.

Lorsque sa masse devient insuffisante, il explose dans une gerbe de

rayonnements (neutrinos, photons, électrons et positons...)

R.I.P. |

S. Weinberg

|

Références

- 1 - R.Feynman: cour de physique quantique

- 1987- ellipse

- 2 - F.Close: apocalypse when?: cosmic

catastrophe

and the fate of the universe - 1988 - W Morrow - NY.

- 3 - S. Hawking : a brief history of

time: from the

big bang to black hole : 1988

- Bantam books

- 4- S. Weinberg: The decay of the proton

- Scientific american - juin

1981

Si le

proton m'était conté...

Des

résultats expérimentaux

troublant viennent jeter un doute sur ce

que l'on croyait savoir

du proton. Si en théorie celui ci était définit

comme un ensemble de 3 quarks s'échangeant des gluons dans

un volume sphérique (hum hum! rien n'est moins sur!) de

8 x 10-16m de rayon, en pratique les choses semblent

plus complexes... Ces fameux gluons (il y en a 8 différents)

se désintégrant allégrement en paires

quark/antiquark

qui à leur tour s'annihilent pour redonner des gluons....

ect (voir schéma). Autrement dit, le proton est une dynamique,

pas une statique...

En plus, il

apparaît que électrons

et protons sont sans volume, ce qui est intellectuellement

gênant...

On aime bien se les imaginer sous forme de petites billes, mais

ce n'est pas ça du tout! Un problème plus gênant

concerne le fait que les protons résistent trop bien aux

collisions que l'on leur fait subir: impossible de les briser

aussi facilement que prévu, impossible de voir un quark

tout seul: il n'existe qu'avec ses deux frères, confiné

dans le proton... Bref comment ces mystérieux gluons arrivent

ils à propager une force qui, contrairement à toutes

les autres, augmente d'intensité avec la distance ? Cette

propriété ébouriffante (en termes savants,

c'est la "liberté asymptotique de la chromodynamique

quantique", de quoi briller dans les salons....) est encore

à expliquer... Que devient même le concept de distance

en dessous de 10-18 m ? J'ai quelques idées là dessus,

bientôt communiquées dans un prochain paragraphe...

Les

lendemains de Démocrite:

et si l'espace temps n'était pas un continuum ?

Depuis fort

longtemps, cette idée

me turlupine, alors pourquoi ne pas vous en faire part? Imaginons

qu'il existe un quantum d'espace-temps, une quantité minimale

de temps et d'espace. Cette quantité minimale,

définissons

là à l'aide du temps de Planck. Toutes les durée

et les dimensions que nous mesurons ne seraient donc que des multiples

entiers de ce quantum. L' ordre de grandeur de ce quantum serait

celui de l'échelle de Planck, autour de 10-35m. Entendons

nous bien, c'est vraiment très petit: la "taille"

d'un de "mes" quantum d'espace temps serait à un proton ce

qu'un unicellulaire est à une galaxie! !

Les fonctions

utilisée en physique

ne pourraient être considérées comme

indéfiniment

dérivables. La continuité de l'espace-temps n'est

qu'une illusion causé par l'échelle de nos observations.

-

Récemment,

les travaux de V Nesvizhevky, basés sur des expériences

de "confinement" de neutrons (on force des neutrons à passer

entres deux plaques très proches et on analyse leur

trajectoire), ont mis en évidence que, pour ces particules,

l'action du champ de gravitation terrestre se manifeste par des

trajectoire non pas paraboliques, continûment variables, mais

quantifiées (en "sauts successifs". A ce sujet, on doit

déplorer que la revue Science & vie ait cru bon de titrer

sur sa "cover" "l'expérience quantique qui contredit Einstein"

car jamais la relativité générale n'a eu la

prétention de décrire le comportement, fut il

gravitationnel, de particules comme le neutron: la relativité

générale possède un champs d'application qui est

celui des très grands objets (planètes, étoiles,

galaxies, univers...). Que les particules élémentaires

voient leur comportement régit par la mécanique quantique

n'est pas à proprement parler une découverte....

-

D'autres travaux expérimentaux ( Ubruh WG - sonic analog of black holes and

the effect of hight frequencies on black hole evaporation - physical

review D, 51, 1995 et R-Parentani - Les trous noirs acoustiques - Pour

la Science 295, 05/2002) portant sur la

propagation des sons dans des fluides montrent également, par

analogie avec le comportement de la lumière, que l'espace temps

pourraît avoir une structure "granulaire" à

l'échelle de Planck.

En fait, je

pense que ce n'est pas la

gravitation qui est de nature quantique, mais l'espace-temps

lui-même:

il serait bien plus fécond de rechercher une

géométrisation

du monde quantique (tout comme la relativité peut être

définie comme une géométrisation de la

'interaction

gravitationelle) plutôt que de rechercher à quantifier

la gravitation.

Imaginez donc

notre espace-temps réduit

à deux dimension, comme un plateau d'échec. Chaque

case représente un quantum spatio-temporel, produit d'une

distance par un temps. Ce que nous appelons matière et

temps ne seraient en fait qu'une déformation affectant

un nombre entier de ces cases, et ces grandeurs pourraient être

décrite sous forme essentiellement géométrique.

Selon notre "angle" de vue, une même déformation

pourrait nous apparaître sous des formes différentes,

ce qui expliciterai en partie la surabondance de particules

élémentaires

découvertes ces dernières années.

Je

découvre ce jour (28/08/2002)

que, comme souvent en sciences, lorsqu'une idée est "dans

l'air", elle est partagée: le professeur Meissen,

célèbre pour ses études des OVNI

(ce qui

n'enlève rien à la valeur de ses idées), a

publié

par ailleurs un article extrémement intéressant

à ce sujet (Spacetime

quantization - elementary particles and cosmology - Foundations

of physics 2000, n°29, 281-316).

Il est possible de le télécharger

sur son site.

De même,

le physicien Joao Magueijo présente dans son ouvrage de

vulgarisation (au titre assez malheureux) "plus vite que la

lumière " (ed Dunod, ISBN 2100072471) paru en octobre 2003

divers modèles envisageant cette possibilité d'un univers

qui ne soit plus un continuum - à noter que cet ouvrage est

aussi une remarquable description de la façon dont se fait la

recherche réelle, et devrait être lu par plus d'un

spécialiste autoproclamé de la "didactique des sciences

expérimentales".

Au

commencement...

L'origine de l'univers à

été

décrite depuis plus de 75 ans par le modèle du big

bang. Rappelons les faits:

- E. Hubble a mis en évidence en 1929

un mouvement d'ensemble des galaxies et des groupes de galaxies qui

s'éloignent de nous, à des vitesses croissantes selon

leur distance: l'univers est donc en expansion, ce qui veut dire qu'il

a été nécessairement à une époque

condensé en un "point" de départ.

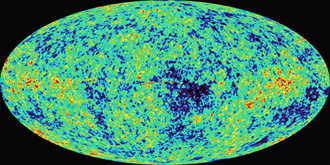

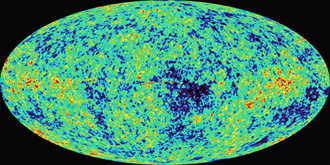

- Penzias et

Wilson ont détectés en 1965 un fond cosmique de

rayonnement qui subsiste de cette explosion primordiale. Ce

"rayonnement à 3K" est ce qui subsiste de nos jour du big bang,

et a été étudié en détail par le

satellite COBE.

-

Ce fond de

rayonnement a été analysé en détail par la

sonde MAP.

|

Distance des objets

(en années lumières)

78 millions

1,4 milliards

3,6 milliards

|

spectres

(2 traits blancs= raies du calcium)

|

vitesses d'éloignement

(en km/s)

1200

22000

81000

|

| Les spectres sont ceux de

galaxies de plus en plus lointaines. |

Les

spectres sont les fuseaux au

centre des images. Au dessus et en dessous, des raies de

référence sont figurées. Noter le

déplacement progressif vers la droite des 2 rais d'absorbtion

(continues) du

calcium. |

La vitesse des galaxies est calculée

d'après le décalage de leurs raies spectrales: elle

augmente en fonction de l'éloignement (v=hd et h constante de

Hubble) |

On en avait

donc déduit

le modèle suivant: au début du temps et de l'espace,

l'univers était une singularité de température

et densité quasi infinie qui aurait "explosé"

il y a 15 milliards d'années (le terme "explosion"

est mal choisi, mais la description du phénomène

échappe à ce point à notre sens commun qu'il

est difficile d'en trouver un autre). L'énergie de cette

"explosion" serait à l'origine de notre univers

qui depuis serait en expansion. La singularité initiale

était indescriptible car les lois connues de la physique

ne s'appliquent que lorsque la densité de l'univers a atteint

la densité de Planck, soit 1097 kg/m3. Notre physique ne nous permet pas de remonter

à l'instant t=0, celui ci ne possédant aucune

signification.

Pendant son

expansion, l'univers s'est

refroidit, les particules s'y sont formées et ont aboutit

à la formation des galaxies et autres objets qui le peuple

actuellement (dont vous et moi).

Cette vision

avait le mérite

de la simplicité et explique bien les abondances relatives

des divers éléments de l'univers. Bien qu'elle reste

vrai dans ses grandes lignes, il est apparu que notre univers

était sans doute bien plus étrange que nous le supposions

il y a peu.

La théorie classique du big bang

générait en effet quelque problèmes. Il faut

en effet bien comprendre que le big bang est un phénomène

s'étant déroulé à l'échelle

subatomique. Il est donc décrit avec la physique des particules

élémentaires. L'approche laissait subsister plusieurs

problèmes:

Tenter de

répondre à ces

questions (sauf la dernière !) n'a rien d'une discussion

oiseuse de philosophes verbeux: ces questions découlent

naturellement des progrès de la physique des particules,

celle la même qui explique le fonctionnement du transistor

et qui permet la fabrication de l'ordinateur ou, fragment conscient

d'un univers à l'indicible étrangeté, je

tape ces quelques mots...

Pour

résoudre les problèmes

liés à la théorie classique du big bang,

une autre théorie à été avancée

et développée, qui complète et prolonge celle

ci: celle de l'univers inflatoire. Nous allons voir que

ses implications sont fantastiques et nous amènent à

réfléchir sur les liens qui unissent l'homme au

cosmos, et sur la façon dont nous pourrions bien devenir

des créateurs d'univers! (en comprimant fortement le vide

quantique, par exemple).

Avant de nous

embarquer, ultime précaution:

un modèle ne prétend pas être une

réalité,

c'est une façon de dire les choses que nous connaissons

et observons à l'heure actuelle. Dans quelques mois, peut

être quelques heures, cet édifice paraîtra

risible, c'est une borne sur le chemin de la connaissance, pas

son aboutissement! Ainsi, et afin que vous puissiez vous faire

une opinion, je vous présenterais par la suite un autre

modèle d'univers, l'univers gémellaire,

imaginé

par A. Sakharov (+ Green, Schwarz et Abdus Salam, bref pas vraiment

des rigolos en proie à des délires subjectifs!) et complété

par J.P. Petit. Vous verrez ainsi qu'il y a (ou qu"il devrait

y avoir), en science, bien des façons d'expliciter un

phénomène!

(voir mes édito).

Dans la suite,

j'utilise a dessein un

ton que d'aucun trouveront péremptoire: l'univers est ceci,

cela, ect... Attention: la

science ne délivre que des vérités à

responsabilité limité

! Ce n'est pas un dogme! J'utilise cette façon de m'exprimer

pour rendre plus attrayant mon doux propos, mais n'oubliez pas

qu'il n'est de vérité que relative ("Bien

dit !" Albert E, de Princeton)

Les champs scalaires, c'est

mieux que ceux des sirènes

L'univers est

baigné, à

baigné et baignera dans des champs scalaires (analogue

au champ électrique). Si un de ces champs est constant

en tout point, nous n'en ressentons pas les effets. Dans notre

univers, les photons transmettent les forces

électromagnétiques

(lumière et chaleur, par exemple) et les bosons W et Z

transmettent les forces nucléaires faibles. W et Z sont

très massifs alors que les photons sont sans masse. Pour

décrire ce qui se passait quand ces deux forces n'en faisait

qu'une, on introduit des champs scalaires. Le plus important est

le champs de Higgs qui en interagissant avec W et Z leur confère

leur masse.

Donc, dans l'univers jeune, toutes les

particules ont une masse nulle. Leur différenciation massique

se fait lorsque l'univers se dilate et se remplit de différents

champs scalaires. La valeur du champ qui apparaît dans un

univers donné est donné par son énergie

potentielle

minimale dans cet univers.

L'univers: histoire d'une monstrueuse

enflure

Au commencement

était une mousse

d'espace-temps. Emplie de champs scalaire soumis à des

fluctuations aléatoires et quantiques. En certains points

de cette mousse, le champs scalaire augmente, ce qui provoque

la création de domaines inflatoires: alors que la vitesse

d'expansion d'un univers purement matériel

décroîtrait

avec sa densité, l'énergie potentielle du champs

scalaire maintient l'expansion car elle décroît bien

moins vite que la densité. L'énergie du champs scalaire

entraîne une expansion très rapide de l'univers (ou

plutôt d'un domaine du multivers qui deviendra notre univers):

c'est l'inflation. Le champ scalaire diminue très lentement

pendant cette dilatation de l'univers, qui s'auto-entretien donc

de façon exponentielle: en 10-35 secondes seulement, l'univers passe d'un

diamètre

de 10-35 cm à un diamètre de 10 puissance 1012 m (donc

nous n'observerions qu'une toute petite partie de l'univers).

En arrivant à son potentiel minimal, le champ scalaire

oscille, et a perdu de l'énergie sous forme de particules

élémentaires: le big bang était né!

Le big bang résulterait

des oscillations du champ d'inflation à l'approche de son

point minimum d'énergie potentielle. Noter que la sortie

du minimum local peut s'être effectuée dans plusieurs

"régions" donnant ainsi naissance à plusieurs

univers dissemblables. Schéma d'après Bucher &

Spergel

Le big bang résulterait

des oscillations du champ d'inflation à l'approche de son

point minimum d'énergie potentielle. Noter que la sortie

du minimum local peut s'être effectuée dans plusieurs

"régions" donnant ainsi naissance à plusieurs

univers dissemblables. Schéma d'après Bucher &

Spergel

Le champ

scalaire se comporte un peu

comme un fluide très visqueux. Pendant l'inflation, des

fluctuations quantiques sont emportées par l'expansion

qui augmente démesurément leur longueur d'onde avant

de les figer. Les premières à se fixer sont celles

qui ont la longueur d'onde la plus grande au départ, suivies

par d'autres. Ces ondes modifient à leur tour la valeur

du champs scalaire, créant des

hétérogénéité

à partir desquelles se formeront les amas de galaxies.

Ces ondes

figées sont extrêmement

importantes: dans les rares régions ou elles renforcent

suffisamment le champs scalaire, elle créent une dilatation

exponentielle: l'univers se peuple donc continûment de

nouveaux domaines inflatoires, il bourgeonne sans cesse...

Ainsi,

l'inflation conduit à

des univers divisés en domaines dans lesquels les lois

et les constantes physiques sont différentes à basse

énergie. Notre univers quadridimentionnel est un cas

particulier ou la vie sous forme humaine est possible, mais sans

cesse l'univers se créée, bourgeonne et dote des

domaines entiers de lois physiques inédites: si l'on

réfléchit

au sens de l'infini, on peut en déduire que toutes les

formes de vies sont possibles dans le "multivers". A

la limite, un univers à la Tex Avery est parfaitement

possible...

(Tu ne rêve pas lecteur, ce n'est pas du délire

héroïnomane

mais de la physique de haut vol!).

Décidément,

cette idée

d'infini en physique nous pose des problèmes... il

semble qu'il faut y réfléchir afin de bien séparer

l'infini des mathématiciens, celui des philosophes et celui

des physiciens, si tant est que le terme "infini" soit

réellement vecteur de sens en physique ou ne soit que le

reflet de notre incompétence actuelle a décrire

certains phénomènes...

Pour expliquer

pourquoi notre univers

est ouvert, on suppose que le champs scalaire, rebaptisé

inflaton, est passé par un minimum local. Dans certaines

régions de l'univers (dont dans notre univers),

l'inflaton est sorti de son minimum local par effet tunnel, et

a déclenché le big bang en oscillant autour de

son potentiel minimum. La sortie du minimum local (appelée

"désintégration du faux vide") n' a pas

été simultanée dans toutes les régions

de l'espace, entraînant la création de plusieurs

"univers bulles" dans lesquels les lois physiques et

surtout la perception du temps ne sont pas identiques.

Les observations

du rayonnement fossile

cosmologique ne sont pas assez précise pour confirmer ou

infirmer cette théorie, mais 2 satellites d'observation

(l'européen Planck prévu pour 2007 et le détecteur

d'anisotropie millimétrique de la NASA, ayant fournit ses

données après 2001) devrait permettre de tester les

conséquences observables

de ces différentes théories.

Actuellement,

les expériences

d'observation a haute résolution du rayonnement cosmologique

au moyen de ballons stratosphériques (Boomerang puis maxima)

tendent a montrer que l'univers serait "plat". Confronté

aux résultats obtenus lors de l'étude des supernovae

lointaines, ce résultats augmente l'importance du

paramètre

"constante cosmologique" dans la description de l'univers:

il semble bien que si la matière attire la matière,

le "vide" la repousse! Ceci tendrait à monter

que notre univers serait en ce moment dans une phase d'expansion,

voire même d'inflation causée par la

prépondérance

de la constante cosmologique sur l'attraction

gravitationnelle, du moins à très grande

échelle

!

Comment décrire l'insoutenable

étrangeté de l'univers ?

"Que celui qui

a des oreilles entende !"

Un peu d'histoire

- 1972

A. Linde et D. Kirzhnit interprètent le développement de

l'univers primordial comme une suite de transition de phases: l'univers

aurait subi une suite de condensations

- 1979

A. Starobinsky formule à Moscou la première

théorie de l'univers inflatoire: basée sur les anomalies

de la gravitation quantique, cette théorie complexe

décrit fort mal l'origine de l'inflation.

| 1981 A. Guth

reprend les travaux de Linde et suppose que

l'univers chaud se soit dilaté de manière exponentielle.

L'univers aurait été en état de surfusion

instable, ce qui aurait déclenché son inflation. De

nombreux problèmes de la théorie classique du big bang

sont ainsi résolus, mais on obtient ainsi un univers trop

hétérogène. |

A.

Guth

|

- 1982

A Linde présente une nouvelle théorie inflatoire, mais

elle reste complexe et conduit à des univers irréalistes

- 1984

A. Guth et P. Steinhardt proposent également une théorie

inflatoire. L'origine de l'expansion exponentielle primordiale de

l'univers reste cependant peu claire.

-

1985

A. Linde étudie l'inflation à partir des théories

des particules élémentaires, et en particulier à

partir des champs scalaires: Cela le conduit à l'inflation

chaotique, une théorie simple et élégante qui

résout les difficultés du modèle classique et

ouvre de vertigineuses possibilités. Elle conduit à des

prévisions confirmées par le satellite COBE. Cependant,

elle conduit à un univers plat. Simultanément, d'autres

idées se développent sur la structure microscopique de la

matière, en particulier les supercordes qui conduisent plus

difficilement à une inflation.

- 1995

Bucher, Goldhaber et Turok montrent qu'un univers ouvert

n'empêche pas l'existence d'une inflation primordiale (Open Universe from inflation - Physical

review D, 52, n°6, 15/09/1995 ).

Ils montrent que l'inflation peut s'être déroulée

en 2 étapes

- 1998

Les observations de supernovae et d'objets lointains montrent que

l'univers n'est pas plat mais ouvert, hyperbolique.

- 1999

Bucher et Spergel présentent comment l'inflation peut conduire

à un univers hyperbolique: notre univers n'est plus qu'un cas

particulier dans un multi-univers ("multivers"). Les conceptions de

Linde y sont amplifiées et corrigées.

-

1999

Contre vents et marées, J.P.Petit et P.Midy tentent de proposer

un autre modèle d'univers, basée sur une

géométrie particulière et une variabilité

des constantes physiques dans le temps, qui permet de résoudre

bien des paradoxes qui handicapent encore le modèle "standart"

-

2000

Les résultats de l'expérience boomerang (cartographie a

haute résolution mais sur une faible étendue du

rayonnement cosmologique) montrent que l'univers serait plat, les

fluctuations de densité du rayonnement cosmologique étant

de l'ordre de 1°; corroborant ainsi les travaux d'A. Linde de 1985.

- 2003

Les résultats de MAP, rebaptisé WMAP en hommage au

physicien Wilkinson, sont obtenus

Lors de la

formation de l'univers, des

structures multidimensionnelles ultradenses appelées supercordes

ont du se former et attirer à elles la matière,

formant des hétérogénéités

dans un univers alors homogène. De ces structures

hétérogènes

serait nées les amas de galaxies et les structures à

grandes échelle de l'univers. Si vous voulez voir ces supercordes,

cliquez ici. Bonne route... Avant de partir, un rappel: bien

que les supercordes soient très étudiées,

elles n'ont pu être directement impliquées jusqu'à

ce jour dans aucun fait observable...

Note (ajout

en 2003) : l'inflation implique que

notre univers, en

fait notre espace, soit "plat". Cependant, les mesures

expérimentales réalisées lors des

expériences

Boomerang et maxima (MAP est en cours d'analyse) montrerai que

la valeur la plus plausible pour le paramètre de

géométrie

de l'univers (W)

est de 1,2, donc en faveur d'un espace fini à grand rayon

de courbure, elliptique. Cependant, aucun modèle

inflationniste

ne prédit W > 1, ce qui semble bien invalider l'inflation!

Les tenants de cette théorie ont alors, apparemment,

analysé

les résultats de ces expériences en faisant comme

hypothèse de départ W =1, ce qui obère fortement leurs conclusions

puisque, après un magnifique raisonnement circulaire, elles

permettent de retrouver leur hypothèse de

départ,

à savoir un espace euclidien....

Le

retour de la constante cosmologique

L'expansion

de l'univers a été mise en évidence dès

1929 par E. Hubble qui découvrit grâce au télescope

du mont Wilson que toutes les galaxies sont emportées dans

un mouvement d'ensemble qui les éloigne les unes des autres:

loin d'être statique comme le pensait A. Einstein, l'univers

est en expansion. Or, A. Einstein, après avoir établit

en 1915 la relativité générale, avait

observé

que sa théorie ne pouvait conduire qu'à un univers

dynamique (soit en expansion soit en contraction). Gêné

par les implications philosophiques de sa découverte, le

grand Albert avait alors sorti de son cerveau puissant une constante

had oc

baptisée "constante cosmologique"

l qui permettait de retrouver un univers stable (enfin, à

première vue).

|

En fait, l permet l'existence d'un

univers isotrope et homogène (supposition prophétique du

grand Albert, vérifié depuis: l'univers possède

bien à grande échelle une structure isotrope et

homogène - enfin, peut être). De plus, l est liée

à l'explication de l'inertie liée à

l'énergie et à la quantité de mouvement

(idée de E. Mach reprise par Einstein). En 1922, A Friedmann

montre que l'univers de la relativité générale

peut être isotrope et homogène mais non statique: il doit

être en expansion ou en effondrement. Quant à

l'intégration de l'inertie dans la relativité

générale, Willem de Sitter résout le

problème par l'invention de l'espace-temps. Eddington et

Lemaitre démontrent également que la constante l ne

permet même pas d'obtenir un univers stable: à la moindre

perturbation (formation de galaxies par exemple), les univers

artificiellement "stabilisés" d'Einstein s'effondrent

lamentablement ou explosent! Einstein le signale dans un courrier

à H Weyl : "s'il n'y a pas de monde quasi statique, alors au

diable le terme cosmologique ")

|

Avec les travaux

de Hubble qui mettent

en évidence l'expansion de l'univers, Einstein confesse

que la constante cosmologique était "la plus grande

erreur de sa vie". Le sort de l est jeté: la constante

cosmologique passe aux oubliettes de la physique, et disparaît

avant même d'avoir reçu un début de commencement

de justification physique. l repose en paix, du moins le croit

on. En fait, elle reste tapie dans les équations de la

relativité et attend son heure...

En 1967, Y

Zeldovitch la ressuscite

! Il lui donne une justification physique: l représente

l'énergie du vide quantique, constante

en tout point de l'univers. Cette énergie doit influer

sur le comportement de l'univers mais personne alors n'en trouve

la trace. On essaye alors de donner pour l des valeurs compatibles

avec la cosmologie: en éliminant les valeurs négatives

qui conduisent à une "supergravitation" telle

que l'univers disparaît en quelques milliers d'années,

il nous reste de nombreuse valeurs disponibles! Nous pouvons

éliminer

également les valeurs trop grandes: l'univers serait alors

en expansion si rapide que la matière n'y existerait pas!

Tout cela nous donne

-1< l < 2 : on est bien

avancé...

Ce qu'il faut

bien comprendre, c'est

que l agit sur l'interaction gravitationnelle: les

propriétés

géométriques de l'espace-temps (notre univers est un espace-temps à

4

dimension, 3 d'espace et une de temps - ce concept a été

avancé par H Poincaré en 1905 dans un travail portant

sur la dynamique de l'électron)

dépendent de la quantité d'énergie qu'il

renferme. Or, e=m (à une constante près, c2), ce qui

veut dire que l'énergie ou la masse, c'est pareil. Outre

matière et rayonnement, la géométrie de l'univers

dépend de l'énergie du vide. Le calcul de cette

quantité à partir du modèle

standard des particules élémentaires donne une

valeur bien trop grande.

Des paires de

particules

(particule/antiparticules)

se forment, surgissant des fluctuations du vide quantique,

interagissent

puis disparaissent dans un temps très court. Elles sont

à l'origine d'une bonne partie de la valeur de l puisque:

|

l = 8pG/C4 x densité

énergétique du vide (dev)

|

- si l < 0, elle aide la gravitation et

ralentit l'expansion de l'univers. Elle se comporte comme une masse

supplémentaire.

- si l > 0, elle contrebalance les effets

de la gravitation et se comporte comme une antigravitation, ou

plutôt, selon mon analyse, une antimasse: l

accélère alors l'expansion de l'univers.

Les observations

continuent alors, et

l embête tout le monde: on fait semblant de l'oublier, mais

l'étude de l'univers lointain rendue plus facile par les

télescopes géants et leurs détecteurs performants

permet d'encadrer plus précisément sa valeur: la

vitesse de l'expansion de l'univers (données par H0, la

constante de Hubble) ainsi que sa densité de matière

permettent de situer 0<

l < 0,7 . C'est alors que

deux équipes de chercheurs (équipe de S. Perlmutter

- Supernova Cosmology Project et celle de B. Schmitt -

Hight Z Supernovae Search) utilisent le rayonnement lointain

des étoiles géantes en explosion (les supernovae)

pour déterminer les valeurs de l et de la densité

de matière dans l'univers. Et c'est là que le

bel édifice du "modèle standard" ou

l = 0, modèle qui arrange tout le monde, vole en éclat:

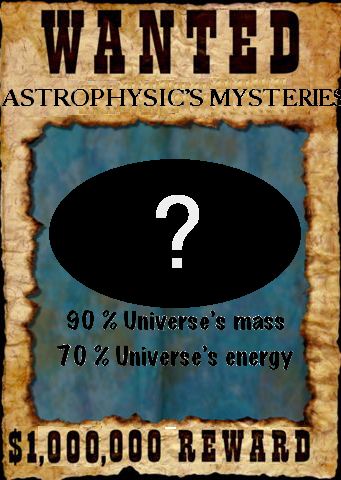

l'étude des supernovae donne l = 0,7 et une densité

de matière dans l'univers voisine de 0,3. Autrement dit,

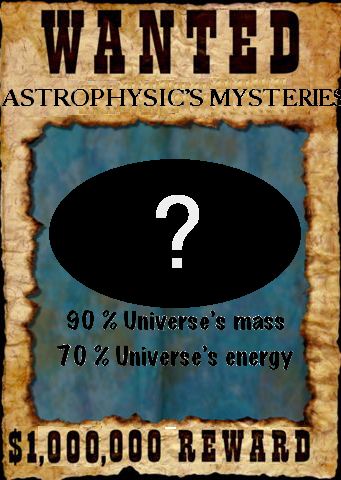

l représente 70% de l'énergie de l'univers !

Seul petit

problème: la physique

quantique, qui étudie la structure microscopique de la

matière, a déterminée pour l'énergie

du vide quantique, liée comme nous l'avons vu à

l, une valeur légèrement trop forte: exactement 10120 fois trop forte

! (soit tout de même, pour ceux fâchés avec

les puissances de 10, un milliard de milliard de milliard de milliard

de milliard de milliard de milliard de milliard de milliard de

milliard de milliard de milliard de milliard de fois trop forte!).

La constante

cosmologique ne correspond

donc apparemment pas tout à fait à l'énergie

du vide quantique... mais alors, qu'est

ce que c'est ? (si vous avez

la réponse, envoyez la sous pli discret à A.Nobel

Fundation - Stockholm - Sweeden ou bien envoyez

moi donc un mail...).

Un

élément de réponse

est apporté par L'astrophysicien JP.Petit, du laboratoire

d'astrophysique du CNRS de Marseille: la constante cosmologique

peut correspondre à l'effet sur notre univers d'un univers

fantôme (ghost universe) qui, interagissant uniquement

avec le notre par le biais de la gravitation, "propulserait"

celui ci. L'expansion de notre univers serait

accélérée

par l' univers fantôme, alors que notre univers freinerai

celle de ce deuxième versant de la réalité.

Rien ne dit non

plus que la valeur de

l soit constante! la DEV peut être variable ( la période

inflatoire pendant laquelle l'univers primitif se serait dilaté

plus vite que la lumière proviendrait de cette variation).

C'est la DEV et non la matière qui détermine le

devenir d'un univers en expansion. Après le big bang, l'univers

se dilate et certaines de ses régions ne peuvent interagir.

Pourtant, l'univers est homogène dans tout les sens:

des régions éloignées de 24 milliards

d'Années

Lumière n'ont pu interagir donc l'uniformité

a du précéder l'expansion. La période

d'expansion inflatoire a éloigné les objets plus

vite que la lumière au début de l'univers. Cet

étirement

de l'espace-temps est provoqué par un champ inflatoire,

l'inflaton, origine de l'antigravité.

Dans le cas le

plus simple, l'expansion

s'est ensuite produite à vitesse constante, et n'est que

localement contrebalancée par la gravité. 300000

ans après le big bang, les atomes d'H apparaissent et l'univers

devient transparent, libérant le rayonnement cosmologique

diffus. Ce rayonnement est homogène avec des différences

plus petite que 1/100000. Comment se sont alors formées

alors les structures comme les amas de galaxies à partie

d'un milieu si homogène au départ ? (des idées

bientôt sur ce site)

il y a donc

visiblement un problème

dans la théorie standard des particules

élémentaires:

l'univers contient de la matière (ou de l'énergie)

inconnue. Il reste également à lier la constante

cosmologique au tenseur de Weyl, qui représente une courbure

non massique de l'espace-temps jouant un rôle dans la

détermination

de la flèche du temps. Si la théorie de l'inflation

est fausse, comment expliquer l'homogéinité de l'univers

?

Les

Mânes

de pythagore: de l'importance de la géométrie en

astrophysique...

Plusieurs difficultés de la cosmologie

ont pour origine des conditions initiales, des

présupposés

dont il faut savoir parfois s'affranchir pour progresser. Comme

en toute science, le dernier mot doit revenir aux observations

: "the tragedy of science is the murder of beautiful theories

by ugly facts" :

-

Les

modèles d'univers font tous la

supposition simplificatrice qu'à grande échelle l'univers

est homogène et isotrope... a bien y regarder, cette

simplification ressemble de plus en plus à un pari

risqué: la cartographie à grande échelle de

l'univers fait apparaître une structure lacunaire, ressemblant

à une mousse de matière visible. Il faudra bien expliquer

comment on est passé de l'homogénéité du

big bang (attestée par l'isotropie du fond cosmique à 3K)

à l'hétérogénéité

apparente actuelle (attestée par nos observations). Il est

d'ailleurs possible qu'actuellement, notre univers ne soit plus

isotrope! En 1997, Noland et Ralston, en étudiant la

polarisation des rayonnements en provenance de galaxies lointaine ont

mis en évidence une direction préférentielle, une

anisotropie électromagnétique à

l'échelle de l'univers. Cet effet est très ténu

mais la direction préférentielle semble s'étendre

en direction des constellations du sextant et de l'aigle.

- La géométrie de

l'espace-temps possède, nous

l'avons vu, une grande importance. Pour ce qui est des modèles

d'univers, elle est déterminante: l'univers peut nous

apparaître plat simplement parce que sa courbure est trop faible

(c'est à dire sa dimension trop grande) par rapport à

l'étendue de nos mesures. Ce fait important est relevé

par l'inénarrable C. Magnan, et doit tempérer les

résultats récents obtenus tendant à confirmer un

univers plat...

-

D'autres

modèles cohérents d'univers peuvent être bâtis sur d'autres

géométries. Il en est ainsi du modèle des

univers jumeaux qui postule l'existence d'un double univers, le

notre et un univers-frère ou la masse, en particulier, adopte un

comportement inverse de celui que nous connaissons. Cette idée a

été proposée, discutée et

développée par Green, Schwarz, Sakharov et Abdus Salam.

Les conséquences de la géométrie de ces univers

liés permettent d'expliquer certaines observations qui mettent

en difficulté le modèle classique de l'inflation.

Apparemment, il permet même d'expliquer bien mieux la

formation et surtout la pérennité des galaxies. Ce

modèle etait explicité avec brio et truculence dans le site de JP Petit mais le contenu scientifique

de ce dernier n'est plus accessible, remplacé par un

délire conspirationniste qui ferait de l'agent Mulder un

modèle d'équilibre et de pondération et de Joseph

Staline un agent secret de la CIA... En

résumé, JP Petit proposait que notre

univers se superpose à un univers fantôme contenant une

matière ombre qui repousse gravitationellement la matière

de notre univers, provoquant ainsi un phénomène de

confinement gravitationnel permettant d'expliciter un grand nombre

de zones d'ombre du modèle standart d'univers (en particulier la

formation et la dynamique galactique). Ce mécanisme de

confinement est essentiel. Vous pouvez former vous même votre

galaxie le matin, en prenant votre café: si vous êtes

observateur, vous avez sans doute remarqué que du lait

ajouté au café mis en rotation, avant de diffuser,

formait une structure en spirale. Celle ci est due au frottement du

liquide avec les parois de la tasse. De la même façon, la

matière ombre se comporte comme la tasse qui freine son contenu

(la galaxie) et lui impose une forme bien déterminée...

-

Paraphrasant

Pythagore et son

célèbre "tout est nombre", une poignée de

scientifiques de premier plan, dégagés d'obligations

universitaires et financièrement indépendants,

prétend que "tout est calcul". Pour les tenants de cette

nouvelle "forme" de science, l'univers tout entier serait

assimilable à un calculateur actualisant en permanent sa propre

dynamique. Tous les processus physiques seraient descriptibles

par des calculs simples se reproduisant de manière cumulative,

itératives, un très grand nombre de fois. Ce

"réductionnisme computationnel" est en fait une synthèse

de plusieurs travaux remontant au début des années 60,

et qui ont été menés indépendamment dans de

nombreuses branches de la physique, de la chimie et de la biologie. Ils

ont pour mérite de montrer, expérimentalement, comment la

complexité peut naitre de la répétition multiple

de processus essentiellement simples. J'ai

publié un article faisant le point de cette approche. En

France,

elle est peu accessible*. Une présentation remarquable en est

fourni par S. Wolfram dans son livre "A New kind of Science".

Premier

modèle

explicatif de Quasar

Les quasars

(quasi stellar radio sources)

sont des objets extrêmement lointains (plusieurs milliards

d'années lumières) rayonnant beaucoup (mais alors

là beaucoup!) d'énergie. La plupart des astrophysiciens

les décrivent sommairement  en

disant

que ce sont des trous noirs supermassifs (107 fois la masse du soleil) environnés

d'un disque d'accrétion. Certains font également

intervenir des phénomènes collisionnels entre galaxies

(bien que 25% des quasars ne montrent absolument aucun signe de

collision... et que de nombreuses galaxies en interaction ne produisent

pas de quasar...). Plus précisément, ces objets

ont un diamètre voisin de celui du système solaire

mais rayonnent autant qu'une galaxie entière! Ils

émettent

également des jets de matière à des vitesses

proches de celle de la lumière (c). En 1998, Bahcall et

Disney ont mis en évidence, en utilisant le télescope

spatial Hubble, qu'au moins 75% des quasars appartiennent à

une structure de type galactique.

en

disant

que ce sont des trous noirs supermassifs (107 fois la masse du soleil) environnés

d'un disque d'accrétion. Certains font également

intervenir des phénomènes collisionnels entre galaxies

(bien que 25% des quasars ne montrent absolument aucun signe de

collision... et que de nombreuses galaxies en interaction ne produisent

pas de quasar...). Plus précisément, ces objets

ont un diamètre voisin de celui du système solaire

mais rayonnent autant qu'une galaxie entière! Ils

émettent

également des jets de matière à des vitesses

proches de celle de la lumière (c). En 1998, Bahcall et

Disney ont mis en évidence, en utilisant le télescope

spatial Hubble, qu'au moins 75% des quasars appartiennent à

une structure de type galactique.

Le quasar PG 0052+251 est

au centre d'une galaxie spirale et émet au moins un jet

( à 1h) photo

J.Bahcall- IAS - NASA

Jusqu'à

ce jour, personne n'avait

proposé de mécanisme expliquant la formation des

quasars. Ce n'est plus le cas. En effet, JP Petit propose (Petit, 1997)

un modèle lié à sa conception de la

géométrie

de l'univers. Je ne puis que renvoyer à

son ouvrage pour plus de détails, mais en résumant,

il propose les idées suivantes:

- notre univers se superpose

à

un univers fantôme contenant une matière ombre qui

repousse gravitationellement la matière de notre univers,

provoquant ainsi un phénomène de confinement

gravitationnel permettant d'expliciter un grand nombre de zones d'ombre

du modèle standart d'univers (en particulier la formation et la

dynamique galactique).

- A la suite d'une augmentation de la valeur

du champ de confinement en provenance de la matière ombre, il y

a formation d'une onde de densité centripète. Cette onde

entraîne les nuages d'hydrogène vers le centre galactique,

provoquant accessoirement l'apparition d'étoiles jeunes qui

ionisent ce gaz, lequel devient un plasma. Ce plasma entraîne

vers le centre galactique les lignes de champ magnétique de la

galaxie, qui se trouve ainsi renforcé.

- Lorsque l'anneau de plasma atteint le

centre galactique, son énergie cinétique est immense.

Température et densité croissent si fortement et si vite

que dans l'ensemble de ce "coeur chaud" se déclenche

à partir de 700000 °C des réactions de fusion

nucléaire. Simultanément, les lignes de champ

magnétique comprimées laissent des "portes de sortie" au

plasma en fusion qui s'(échappe par les pôles de ces

champs. On obtient alors des jets de matière à des

vitesses proches de C, accélérées qui plus est par

la décroissance du champ magnétique en fonction de la

distance à la source...

Le

neutrino enfin lourd !

Dès 1930, le remarquable

physicien

W.

Pauli, découvreur du spin de l'électron et du

principe qui porte son nom, avait supposé l'existence

d'une particule nouvelle susceptible d'emporter l'énergie

qui manquait après certaines réactions nucléaires.

Cette particule, que Fermi nomma neutrino,

possède la particularité d'être difficilement

détectable, car elle se lie très peu avec les autres

particules: voyageant à la vitesse de la lumière,

65 milliards de ces particules traversent à chaque seconde

chaque centimètre carré de votre corps. Ils traversent

le Terre comme si de rien n'était, et ce "bombardement"

est donc permanent.. En

1956, ces particules produites dans un réacteur nucléaire

ont été détectées pour la première

fois, mais dès 1967 un irritant problème se

posa: La quantité observée de neutrinos solaires

était très inférieure à la quantité

calculée: des neutrinos manquaient à l'appel!

Pour expliquer ce déficit, on devait soit incriminer le

soleil, qui ne devait pas fonctionner comme on le croyait, soit

croire que les neutrinos ne se comportaient pas comme prévu.

En fait, il existe trois types de

neutrinos,

et les détecteurs n'en mettait en évidence, avec

peine, qu'un seul. On pouvait croire que les neutrinos pouvaient

se transformer d'une espèce dans l'autre au cours de leur

voyage, et ainsi le déficit observé trouverai son

explication. En 2002, plusieurs expériences (SNO,

Kamland, super

Kamiokande) ont montré qu'en effet, les neutrinos peuvent

se transformer d'une espèce dans l'autre (dès

1998, il était établi que les neutrinos non solaires

pouvait se comporter ainsi).

Ces résultats sont

importants,

car les neutrinos ne peuvent posséder un tel comportement

si ils ont une masse nulle: le neutrino est donc massif. Ors,

les neutrinos sont si nombreux qu'ils "pèsent"

a eux seul autant que toute la matière visible de l'univers...

Leur contribution à

la géométrie de l'univers n'est donc pas

négligeable.

Autre conséquence, il est

possible,

à présent que l'ordre de grandeur de la masse des

neutrinos est connue, de les situer par rapport aux autres

particules...On

constate alors qu'ils se situent bien à l'écart

de ces dernières.... Fait encore plus troublant, si, comme

le modèle standard des particule le postule, la masse est

donnée par une particule a découvrir, le

boson de Higgs (tous les physiciens nucléaires sont

sur sa piste!), ce boson ne peut donner une masse aux neutrinos...

On a donc le problème suivant:

- si le neutrino est non massif,

alors

le soleil ne peut fonctionner comme on le pense

- si le neutrino est massif,

alors

l'ensemble des particules matérielles ne peut tirer sa masse du

processus postulé jusqu'ici.

Et comme le neutrino

possède

une masse.... il va falloir compléter

le modèle standard, credo de la physique depuis plus

d'un demi siècle...

REFERENCES

- Abbott L.: Le

mystère de la constante cosmologique /Pour la Science/ 07/1988

- Arkani-Hamed N. et al.; Les dimensions

cachées de l'univers /Pour

la Science/10/2000

- Brunier S. et al.: L'univers

emporté par le vide / Ciel & espace 346/ 03/ 1999

- Broch H. Le paranormal, documents,

hommes et méthodes.

ed. Seuil - point sciences, 1989

- Broglie. La physique nouvelle et les

quanta. Ed Flammarion,

Champs, 1986 (écrit en 1936, revu en 1973)

- Bucher M; et al.; L'inflation de

l'univers /Pour la Science/

03/1999

- Corby H. et al.; Paul Dirac et la

beauté de la physique /Pour la Science/ 07/1993

- De Witt B., La gravitation quantique/Pour la Science/ 02/1984

- Disney M. Un regard nouveau sur les

quasars / Pour la Science

250/ 08/1998

- Freedman D.Z et al., Les

dimensions

cachées de l'espace-temps / Pour la Science/ 07/1985

- Freedman W.: L'expansion de l'univers

/Pour la Science/ 01/1993

- Gale. G.: Le principe anthropique /Pour la Science/ 02/1982

- Green MB, Schwarz JH. Nucl. Phys. 181, 1981 et198, 1982

- Guth A. et al. L'univers inflatoire

/Pour la Science/ 07/1984

- Heisenberg W. Le manuscrit de

1942 - ed Allia, 2003

- Hogan C et al.: Des supernovae pour

sonder l'espace temps /Pour

la Science/ 03/1999

- James P et al.. L'évolution de

l'univers /Pour la Science/

12/1994

- Krauss L.M.: The end of the age

problem, and the case for a cosmological constant revisited/ Astrophysical journal 494/ 10/02/1998

- Krauss L.: L'antigravité /Pour la Science/ 03/1999

- Linde A. L'univers inflatoire

autoreproducteur /Pour la

Science/ 207/01/1995

- Luminet J.P. Les trous noirs - ed. Seuil - point sciences, 1992

- Luminet J.P. L'univers chiffonné

- ed. Fayard - le temps de

sciences, 2001

- Mc

Donald A, Klein J, Wark D. L'énigme

des neutrinos solaires résolue. Pour la Science/ 312/10/2003

- Midy P et Petit

JP: scale invariant

cosmology

- Ortoli S,

Pharabod JP.. Le cantique

des quantiques - le

monde existe t'il ? - ed. la découverte - essai, 1998

- Ortoli S,

Witkowski N. La baignoire

d'Archimède - petite

mythologie de la science - ed. Seuil - point sciences, 1998

- Petit JP: on

a perdu la moitié

de l'univers - ed Albin

Michel, 1997

- Riess A.G. et

al.: Observationnal

evidence from supernovae for an accelarating Universe and a

cosmological constant / Astrophysical

journal 116 - 3 / 09/1998

- Rith K, Schäfer A.: Le spin des

nucleons / Pour la Science

262, 08 - 1999, 82-89

- Sakharov A. Modéles

cosmologiques d'expansion/contraction de l'univers - J Exp Th Physics 83, N°44, 1982

- Sakharov A. Transitions cosmologiques

avec changement dans la signature métrique - SLAC 0211, 05/1984

- Sakharov A. Modéle cosmologique

de l'univers comportant une inversion du vecteur temps - OSS, 1980, 143-148

- Veltman M. Le Boson de Higgs /Pour la Science 111/ 1/1987

(article que j'ai

rédigé pour la revue effervescience, paru dans le N°

30 de Mars 2004)

"La science est le lieu ou les hommes de

notre époque sont face à la vérité”

W. Heisenberg

De récents résultats

obtenus dans l’étude des phénomènes

complexes

montrent que l’univers dans son entier pourrait

n’être qu’un

processus calculatoire. Dès lors, la conscience elle même

pourrait n’être qu’une propriété

émergente

susceptible d’être simulée. Est-ce

déjà le

cas ?

Une idée ancienne

Platon, avec son mythe de la caverne,

avait déjà envisagé la possibilité que nos

perceptions conscientes ne soient que l’ombre d’une

réalité inconnaissable, les phénomènes

naturels n’étant que les ombres de formes

éternelles.

Avant lui, Pythagore et son école affirmaient que la seule

réalité, c’était le nombre (ou plus

exactement les

entités géométriques décrites par des

nombres), le reste étant illusion. Le courant de pensée

qui fait de la réalité une suprême illusion se

retrouve tout au long de notre histoire, sous des formes diverses, des

aphorismes du chinois Tchouang -tseu (1) à

l’idéalisme de Berkeley et aux écrits de Leibniz;

de

certains jeux de rôles des années 80 à la trilogie

cinématographique “matrix” ! Le point commun

à toutes ces

conceptions est de postuler que derrière l’apparente

complexité de la réalité se cache une harmonie

mathématique secrète dont nous ne voyons que

l’incertain

reflet. Le “calme” débat philosophique

autoréférent sur ces sujets a été

bousculé depuis le début des années 1990 par de

surprenantes découvertes qui en font, nous l’allons voir,

toute

l’actualité.

Le réductionnisme

Cartésien face à son destin

L’importance des phénomènes complexes a

été révélé petit à petit

lorsque de nombreuses disciplines scientifiques se sont trouvées

confrontées aux limites du réductionnisme, aux

frontières de la méthode cartésienne. En effet,

l’étude de nombreux systèmes composé de

plusieurs

éléments en interaction montre que le comportement du

système ne peut être prévu par l’étude

séparée de chacun de ses éléments: leurs

combinaisons font surgir des comportements inattendus, et le tout est

plus, comme le disait Aristote, que la somme de ses parties.

Il est facile d’illustrer ce concept par l’exemple

d’un tas de

sable: si l’on se concentre sur la position, les interactions et

le

bilan des forces s’exerçant sur chacun de ses grains,

l’évolution d’un tas de sable est impossible

à

prévoir. Par contre, en se limitant à quelques variables

globales (hauteur et rayon du cône de sable), cette

évolution devient tout à fait déterminée.

Le point clé est qu’ici la décomposition du

système à étudier en facteurs plus petit augmente

inutilement la complexité de l’ensemble à analyser.

L’approche réductionniste trouve ici sa limite, qui est

celle

d’une complexité croissante induite par la

décomposition

dun système en ses divers éléments, et elle est

particulièrement mise en évidence par

l’étude des

organismes vivants. En effet, le lent démontage des organismes,

de la cellule aux organites, puis aux molécules et maintenant au

génome, a permis d’énormes progrès mais

montre

actuellement ses limites: comment mettre en relation les énormes

volumes de données collectées par l’analyse des

génomes? Les biologistes sont conduit à élaborer

de nouveaux modèles prenant la forme de réseaux

permettant de mieux décrire l’interaction des

différents

éléments qui est à la source des

singularités du vivant.

Alors que se construisait la biologie

moléculaire, dans les années 50, une autre approche,

balbutiante, allait se focaliser sur la simulation du comportement des

organismes au moyen d’automates, éléments

graphiques

obéissant à des règles mathématiques

précises. Comme souvent, cette approche exotique,

théorique et ignorée de la plupart des biologistes allait

fournir le socle de ce qui pourrait constituer une remise en cause

radicale de nos conceptions...

Où les mathémagiciens

s’en mêlent

C’est l’un des plus grand mathématiciens du

20ème

siècle, J. von Neumann, qui mis au point ces automates,

inventés par S. Ulam dans le but de modéliser les

caractéristique d’auto-reproduction des êtres

vivants. Par

la suite, les premiers spécialistes de l’informatique ont

mis au

point des simulations basées sur le comportement de ces

automates, reproduisant les systèmes à étudier. Un

de ces programmes est le “jeu de la vie” de J.H. Conway (

2),

mis au point en 1969 et simulant l’évolution d’une

population de

cellules vivantes.

A quoi ressemblent ces “automates cellulaires”? Les

plus simples

se représentent le plus souvent sous forme d’une grille,

chaque

ligne représentant une avancée d’une unité

temporelle. Le “comportement” (couleur par exemple)

d’une case de la

grille dépend de celui des grilles adjacentes au moyen

d’une (ou

de plusieurs) règle particulière. Pour des automates

très simples, il n’existe que 256 règles possibles

décrivant l’évolution de chaque case lorsque

l’on avance

d’une ligne dans le temps. Lorsque qu’une de ces

règle est

appliquées, il se crée alors un ensemble de motifs qui

adoptent un comportement pour le moins surprenant.

Dès 1936, les mathématiciens K. Gödel, A. Church et

le père de l’informatique, Alan Turing, ont posé

les

bases de la théories de la calculabilité et se sont

intéressés au calcul mécanique. Dans ce cadre,

Turing a montré que des automates cellulaires peuvent constituer

ce que l’on appelle des “calculateurs universels”, et

sont en fait

théoriquement susceptibles de réaliser l’ensemble

des

calculs possibles. Il en découle que si les

phénomènes, même les plus complexes, sont

calculables, alors ils peuvent l’être par des automates

cellulaires adéquats.

Mais qu’appelle t’on complexité d’un

système ? Trois

chercheurs (Kolmogorov, Solomonoff et Chaitin, que nous retrouverons)

ont mis au point une mesure de la complexité d’un

système, dite complexité de Kolmogorov.

L’intéressant est que cette mesure nécessite

l’utilisation des conceptions de Turing: la complexité

d’un

système se défini par la longueur du plus petit programme

susceptible de l’engendrer (

3). Cette approche

s’est

révélée particulièrement précieuse

pour la description mathématique de phénomènes

physiques tels que l’entropie où encore celle de la

complexité croissante des systèmes apparaissants au cours

de l’histoire de l’univers (

4).

Cette possible intrusion des mathématiques dans la biologie

n’a

pas été accueillie avec enthousiasme par la

majorité des biologistes, souvent fâchés depuis

l’enfance avec cette discipline. De plus, la simulation a

mauvaise

presse, particulièrement en France, chez les biologistes, aussi

bien dans l’enseignement, où elle est quasiment

abhorrée,

que dans la recherche où elle ne suscite le plus souvent

qu’un

intérêt poli. Cependant, des résultats

intéressants ont déjà été obtenus

par l’étude d’automates cellulaires: en 1995, le

comportement

des cellules de l’utérus a pu être

modélisé (

5)

de façon à étudier le mécanisme du

déclenchement de l’accouchement. Le développement

des

structures en feuillets caractéristiques du début de

l’embryogenèse a aussi pu être reproduit de cette

façon (

6) ainsi que, plus prosaïquement,

celui du follicule pileux, très étudié en

cosmétologie. Le comportement des vrai cellules semble bien

pouvoir être décrit par celle des cellules virtuelles

d’un

univers mathématique. Malgré tout, ces étranges

grilles pour informaticiens semblaient ne posséder qu’une

utilité exotique et se cantonner à un rôle

accessoire pour scientifiques fana d’ordinateurs en manque

d’excentricités.

Cependant, le potentiel insoupçonné des automates

cellulaires n’allait pas tarder à se révéler

sous

la plume de physiciens passé maîtres dans la

modélisation des systèmes complexes qui résistent

à l’analyse classique. Ils allaient oser étendre la

pertinence du concept à la base des automates, à savoir

la possibilité qu’un calcul simple

répété

engendre des comportements complexes, à l’univers entier.

Ceux par qui le scandale arrive

Nos trois larrons entrent en scène vers le milieu des

années 1990. Il s’agit de S. Wolfram, E. Fredkin et S.

Lloyd. Ce

sont des chercheurs d’un genre un peu particulier dont

l’activité a été abondamment

commentée,

souvent en termes peu amènes, par les cercles

académiques. Issus de l’industrie informatique, ces

individus

cumulent des défauts rédhibitoires aux yeux de

l’establishment:

- ils ont fait fortune dans le

software, et sont donc totalement indépendants des institutions

que par ailleurs ils créent où financent parfois, ce qui

les affranchit des compromissions inhérentes à la

nécessaire conservation d’un emploi de chercheur dans un

cadre

universitaire classique ainsi que de l’usage de la diplomatie

résultant de l’insertion dans le cadre hiérarchique

d’un

laboratoire de recherches.

- leur envergure intellectuelle est

telle que l’on ne peut se permettre de les traiter comme de doux

dingues qui passent leur temps à ratiociner sans fin sur des

sujets qui les dépassent

- indépendants dans leur

pensée, la publication de leur résultats ne suit pas les

voies académiques habituelles. Ils ne se sentent pas tous

obligés de publier dans des revues savantes au lectorat

évanescent mais préfèrent s’éditer

eux-mêmes et faire confiance au réseau internet pour

diffuser leur idées (7, 8, 9). Par là

même, ils s’affranchissent du contrôle tatillon et

des

coups de ciseaux qui donnent aux articles le ton scientifiquement

correct correspondant à des notes écrites pour des motifs

essentiellement administratifs et qui rendent la lecture des sujets les